Es kommt oft vor, dass scheinbar versteckte Rechenzentren das Rückgrat unseres Internets sind. Sie transportieren, speichern und übertragen Informationen, die wir jeden Tag erstellen.

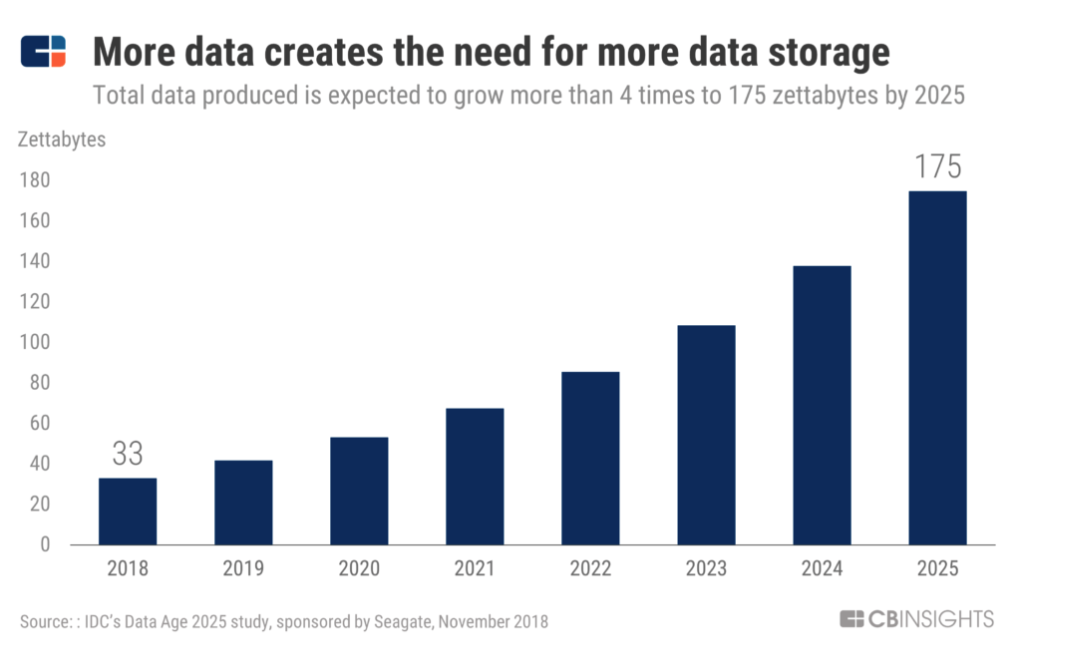

Je mehr Daten wir erstellen, desto wichtiger werden Rechenzentren.

Heutzutage sind viele Rechenzentren unangemessen, nicht effizient und veraltet. Damit sie in gutem Zustand bleiben, arbeiten die Betreiber von Rechenzentren, von FAMGA bis hin zu Colocation-Zentren, daran, sie zu modernisieren, um mit den Trends einer sich ständig verändernden Welt Schritt zu halten.

In diesem Vortrag beschäftigen wir uns mit vielen Aspekten der Zukunft von Rechenzentren und ihrer Entwicklung. Ausgehend davon, wo und wie sie erstellt werden, welche Energie sie verbrauchen und welche Hardware in ihnen ausgeführt wird.

Standort

Glasfaserzugang, Tarife für Energiequellen und Umwelt spielen bei der Auswahl eines Standorts für ein Rechenzentrum eine wichtige Rolle.

Nach einigen Schätzungen könnte der weltweite Markt für den Bau von Rechenzentren bis 2025 bis zu 57 Mrd. USD erreichen. Dies ist eine ausreichend große Herausforderung, da der gewerbliche Immobilienriese CBRE eine ganze Abteilung gegründet hat, die sich auf Rechenzentren spezialisiert hat.

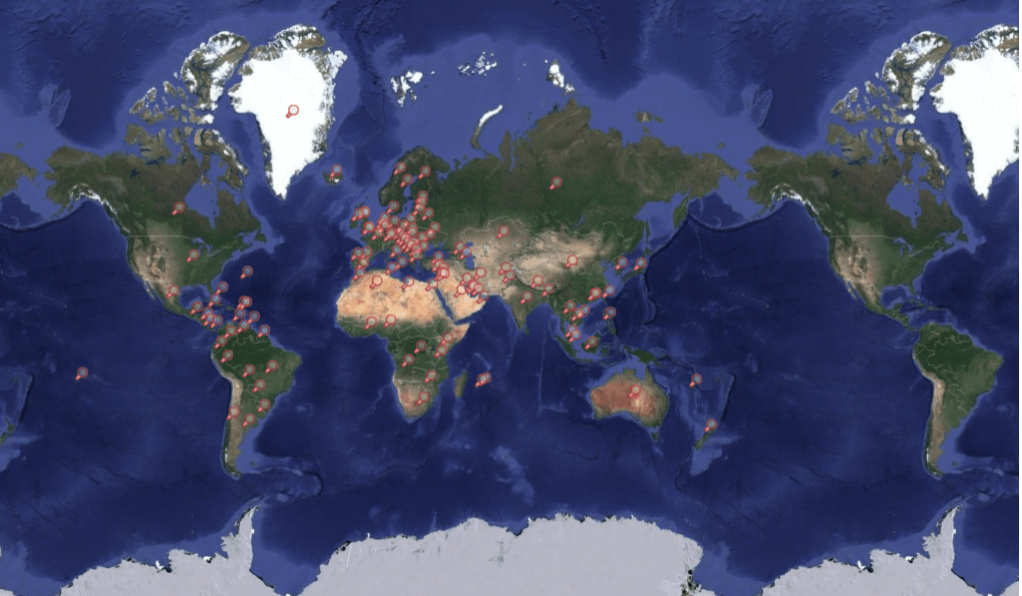

Karte der Rechenzentren

Bauen in der Nähe billiger Energiequellen

Wenn Sie stromhungrige Rechenzentren neben billigen Stromquellen platzieren, können diese kostengünstiger betrieben werden. Da die Emissionen zunehmen und große Technologieunternehmen zunehmend schmutzige Energie zur Stromversorgung von Rechenzentren verwenden, sind grüne Energiequellen ein wichtiger Faktor

Apple und Facebook bauten Rechenzentren neben Wasserkraftressourcen. In der Innenstadt von Oregon hat Apple ein Wasserkraftprojekt erworben, um sein Rechenzentrum in Prinville mit Ökostrom zu versorgen. Das Unternehmen sagte, Oregons deregulierte Strommärkte seien der Hauptgrund für den Bau mehrerer Rechenzentren in der Region. Durch die Deregulierung kann Apple Strom direkt von Drittanbietern kaufen, die erneuerbare Energiequellen nutzen, nicht nur von lokalen Versorgungsunternehmen.

In Lulea, Schweden, hat Facebook neben einem Wasserkraftwerk ein Daten-Megazentrum errichtet. In Schweden tauchten in der nördlichen Region Rechenzentren auf, da neben dem kühlen Klima und dem nicht erdbebengefährdeten Standort in diesem Teil viele erneuerbare Energiequellen (Wasserkraft und Wind) vorhanden sind.

Bau von Facebook in Lulea, Schweden im Jahr 2012. Quelle: Facebook

Mehrere große Rechenzentren sind bereits in die Nordregion gezogen, einige haben es nur im Auge.

Im Dezember 2018 gab Amazon Web Services die Eröffnung seines Rechenzentrums AWS Europe Region bekannt, das etwa eine Autostunde von Stockholm entfernt liegt. Im selben Monat erwarb Microsoft 130 Hektar Land in zwei benachbarten Teilen Schwedens, in Gavle und Sandviken, mit dem Ziel, dort Rechenzentren zu errichten.

Rechenzentrumsunternehmen sind nicht nur in der Nähe billiger, sauberer Energiequellen, sondern achten auch auf das kühle Klima. Durch Standorte in der Nähe des Polarkreises wie Nordschweden könnten Rechenzentren Kühlkosten sparen.

Das Telekommunikationsunternehmen Altice Portugal sagt, dass sein Rechenzentrum in Covilhã 99% seiner Außenluft zur Kühlung seiner Server verwendet. Das alte Rechenzentrum von Google in Hamina, Finnland, verwendet Meerwasser aus dem Finnischen Meerbusen, um die Anlage zu kühlen und den Energieverbrauch zu senken.

Verne Global hat in Island einen Campus eröffnet, der an lokale Geothermie- und Wasserkraftquellen angeschlossen ist. Es befindet sich auf dem Gebiet der ehemaligen NATO-Basis und zwischen Europa und Nordamerika - den beiden größten Datenmärkten der Welt.

Bauen in Schwellenländern

Durch die Platzierung eines Rechenzentrums an einem wachsenden Internet-Verkehrspunkt wird die Last verringert und die Geschwindigkeit der Datenübertragung in der Region erhöht.

Beispielsweise beherbergte das chinesische Unternehmen Tencent, dem Fortnite und WeChat gehören, 2018 Rechenzentren in Mumbai. Der Umzug ist ein Zeichen dafür, dass die Region das Internet aktiv nutzt und die Spieleplattformen von Tencent immer beliebter werden.

Der Bau von Rechenzentren in internetintensiven Bereichen ist ebenfalls ein strategischer Geschäftsschritt. Wenn sich lokale Unternehmen entwickeln, werden sie erwägen, ihren Betrieb in das nächstgelegene Rechenzentrum zu verlagern.

Rechenzentren haben auch eine Colocation-Funktion. Dies bedeutet, dass sie dem Gebäude Kühlung, Strom, Bandbreite und physische Sicherheit bieten und den Speicherplatz dann an Kunden vermieten, die ihre Server und Speicher dort installieren. Der Colocation-Service konzentriert sich in der Regel auf Unternehmen mit geringem Bedarf und hilft Unternehmen, Geld für die Infrastruktur zu sparen.

Steuerliche Anreize und lokale Gesetze

Informationszentren sind eine wichtige neue Einnahmequelle für Stromerzeuger, und daher zieht der Staat große Unternehmen mit verschiedenen Vorteilen an.

Ab Januar 2017 senkte die schwedische Regierung die Steuer auf Strom, der von Rechenzentren verbraucht wird, um 97%. Strom in Schweden ist relativ teuer und die Steuersenkungen haben Schweden mit anderen skandinavischen Ländern gleichgesetzt.

Im Dezember 2018 handelte Google eine Steuerbefreiung für den Verkauf eines Rechenzentrums in New Albany, Ohio, für einen Zeitraum von 100% 15 Jahren für ein 600-Millionen-Dollar-Rechenzentrum aus. Der Vorteil wurde mit der Option einer Verlängerung bis 2058 angeboten. Im September 2018 kündigte Frankreich in der Hoffnung, nach dem Brexit wirtschaftliche Talente und globales Kapital anzuziehen, Pläne zur Senkung der Stromsteuern für Rechenzentren an.

In einigen Fällen ist die Einrichtung eines Datenspeicherungs- und -verarbeitungszentrums eine der Möglichkeiten, wie Unternehmen in Ländern mit strengen Vorschriften weiterarbeiten können.

Im Februar 2018 begann Apple, Daten an einem zentralen Ort in Guizhou, China, zu speichern, um den örtlichen Vorschriften zu entsprechen. Früher mussten die chinesischen Behörden das US-Rechtssystem verwenden, um auf Informationen von chinesischen Bürgern zuzugreifen, die im US-Rechenzentrum gespeichert waren. Jetzt bietet das lokale Rechenzentrum den chinesischen Behörden einen einfacheren und schnelleren Zugriff auf Informationen von chinesischen Bürgern, die in der Apple Cloud gespeichert sind ...

Während die chinesischen Behörden zuvor das US-Rechtssystem durchlaufen mussten, um Zugriff auf die Informationen chinesischer Bürger zu erhalten, die im amerikanischen Rechenzentrum gespeichert sind, bietet das lokale Rechenzentrum den Behörden einen einfacheren und schnelleren Zugriff auf Informationen über chinesische Bürger, die in der Apple Cloud gespeichert sind.

Glasfaserverbindung und Sicherheit

Weitere zwei wichtige Faktoren für den Standort von Rechenzentren sind die Glasfaserkonnektivität und die hohe Sicherheit.

Glasfasernetze sind seit vielen Jahren ein Schlüsselfaktor für die Entscheidung, wo Rechenzentren gebaut werden sollen. Obwohl die Daten häufig über drahtlose Netzwerke oder lokales WLAN auf mobile Geräte übertragen werden.

Meistens werden Daten über Glasfaserkabel zum und vom Speicher verschoben. Glasfaser verbindet Rechenzentren mit Mobilfunkantennen, Heimroutern und anderen Speichergeräten.

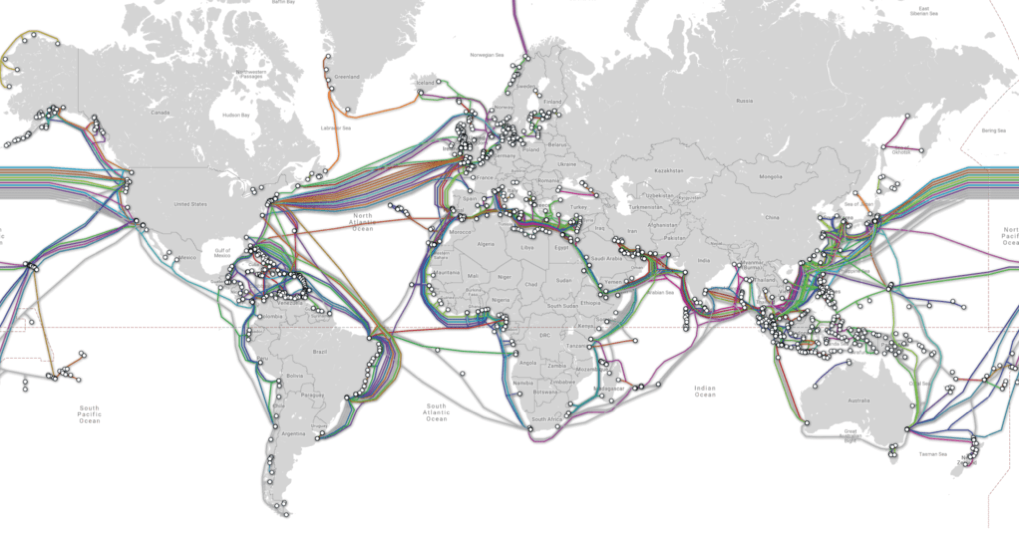

U-Boot-Kabelkarte

Ashburn, Virginia und seine Nachbarregionen haben sich zu einem großen Markt für Rechenzentren entwickelt, was zum großen Teil dem großen Glasfasernetzwerk zu verdanken ist, das AOL als Hauptsitz eingeführt hat. Während andere Unternehmen wie Equinix in die Region gezogen sind und eigene Rechenzentren gebaut haben, wachsen die Glasfasernetzwerke der Region weiter und ziehen immer mehr neue Rechenzentren an.

Facebook investierte fast 2 Milliarden US-Dollar in ein Rechenzentrum in Henrico, Virginia, und im Januar 2019 erhielt Microsoft zum sechsten Mal einen Zuschuss von 1,5 Millionen US-Dollar für die Erweiterung seines Rechenzentrums in Southside, Virginia.

Neue Alternativen zu Glasfasernetzen entstehen auch, wenn große Techniker ihre eigene Konnektivitätsinfrastruktur aufbauen.

Im Mai 2016 gaben Facebook und Microsoft bekannt, dass sie zusammenarbeiten, um ein U-Boot-Kabel zwischen Virginia Beach (Virginia) und Bilbao (Spanien) zu verlegen. Im Jahr 2017 kündigte Facebook Pläne an, ein eigenes 200-Meilen-Glasfasernetz in Las Lunas, New Mexico, zu errichten, um sein Rechenzentrum in New Mexico mit anderen Serverfarmen zu verbinden. Das unterirdische Glasfasersystem wird drei einzigartige vernetzte Routen für die Informationsreise nach Las Lunas schaffen.

Ein weiterer wichtiger Punkt ist neben der Konnektivität die Sicherheit. Dies ist besonders wichtig für Rechenzentren, in denen vertrauliche Informationen gespeichert werden.

Beispielsweise hat der norwegische Finanzriese DNB in Zusammenarbeit mit dem Rechenzentrum Green Mountain ein eigenes Rechenzentrum eingerichtet. Green Mountain hat das Rechenzentrum von DNB in einer erweiterten Sicherheitseinrichtung untergebracht, einem umgebauten Bunker in einem Berg. Das Unternehmen behauptet, dass der Berg vollständig vor allen Arten von Gefahren geschützt ist, einschließlich Terroranschlägen, Vulkanausbrüchen, Stürmen und Erdbeben.

Das Rechenzentrum Swiss Fort Knox befindet sich unter den Schweizer Alpen, deren Tür als Stein verkleidet ist. Das komplexe interne System umfasst viele Tunnel, auf die nur mit entsprechender Freigabe zugegriffen werden kann. Das Rechenzentrum ist durch Notdieselmotoren und ein Luftdrucksystem geschützt, das das Eindringen von giftigem Gas in die Räumlichkeiten verhindert.

Das schwedische Fort Knox ist physisch und digital hochsicher. Quelle: Mount 10

Aufgrund der hohen Serversicherheit in einigen Rechenzentren gibt es viele Rechenzentren, deren Standort noch nie bekannt gegeben wurde. Informationen über den Standort dieser Zentren können als Waffe verwendet werden.

Im Oktober 2018 veröffentlichte WikiLeaks eine interne AWS-Objektliste. Zu den durchgesickerten Informationen gehörte die Tatsache, dass Amazon ein Bieter war, um eine private Cloud im Wert von etwa 10 Mrd. USD für das Verteidigungsministerium aufzubauen.

WikiLeaks selbst hatte Schwierigkeiten, ein geeignetes Rechenzentrum für das Hosting seiner Informationen zu finden. AWS hat das Hosting von WikiLeaks eingestellt, weil das Unternehmen gegen die Nutzungsbedingungen verstoßen hat - nämlich freigegebene Dokumente, für die es keine Rechte hatte, und Personen gefährdet hat.

Infolgedessen ist WikiLeaks in viele verschiedene Rechenzentren umgezogen. Zu einem bestimmten Zeitpunkt gab es sogar Gerüchte, dass WikiLeaks erwägen würde, sein Rechenzentrum im nicht anerkannten Bundesstaat Sealand in der Nordsee im Meer zu platzieren.

Struktur

Während der Standort möglicherweise der wichtigste Faktor ist, um das Risiko einer Fehlfunktion des Rechenzentrums zu verringern, spielen Rechenzentrumsstrukturen auch eine wichtige Rolle bei der Gewährleistung von Zuverlässigkeit und Langlebigkeit.

Durch den ordnungsgemäßen Bau des Rechenzentrums kann es gegen seismische Aktivitäten, Überschwemmungen und andere Arten von Naturkatastrophen resistent werden. Darüber hinaus können Strukturen für den Ausbau angepasst werden, wodurch die Energiekosten gesenkt werden.

In allen Branchen - vom Gesundheitswesen über die Finanzierung bis hin zur Fertigung - verlassen sich Unternehmen auf Rechenzentren, um den wachsenden Datenverbrauch zu unterstützen. In einigen Fällen sind diese Rechenzentren möglicherweise proprietär und befinden sich an Ort und Stelle, während andere gemeinsam genutzt und remote angeordnet werden können.

In jedem Fall stehen Rechenzentren im Zentrum der wachsenden technologischen Welt und erleben weiterhin ihre eigenen physischen Veränderungen. Laut CB Insights Market Sizing wird der weltweite Markt für Rechenzentrumsdienste bis 2020 auf 228 Milliarden US-Dollar geschätzt.

Eine der neuesten Veränderungen beim Aufbau von Rechenzentren ist die Größe. Einige Rechenzentren sind kleiner und weiter verbreitet (sie werden Edge-Rechenzentren genannt). Gleichzeitig sind andere Rechenzentren immer zentraler geworden als je zuvor - dies sind Mega-Rechenzentren.

In diesem Abschnitt betrachten wir die Peripherie und Megazentren von Rechenzentren.

Periphere Rechenzentren

Kleine verteilte Rechenzentren, sogenannte Edge-Rechenzentren, werden erstellt, um hyperlokalen Speicher bereitzustellen.

Während Cloud Computing traditionell als zuverlässiges und kostengünstiges Mittel zur Verbindung vieler Geräte mit dem Internet diente, hat das kontinuierliche Wachstum von IoT und Mobile Computing die Bandbreite von Rechenzentrumsnetzwerken belastet.

Edge Computing bietet nun eine alternative Lösung. (Edge-Computing ist ein Paradigma für verteiltes Computing, das für Endgeräte erreichbar ist. Diese Art von Computing wird verwendet, um die Netzwerkantwortzeit zu reduzieren und die Netzwerkbandbreite effizienter zu nutzen.)

Dazu müssen die Computerressourcen näher an dem Ort platziert werden, von dem die Daten stammen (z. B. Motoren, Generatoren oder andere Elemente). Auf diese Weise reduzieren wir die Zeit, die erforderlich ist, um Daten an zentralisierte Computerstandorte wie Clouds zu verschieben.

Obwohl diese Technologie noch in den Kinderschuhen steckt, steckt sie noch in den Kinderschuhen Es bietet bereits eine effizientere Datenverarbeitungsmethode für zahlreiche Anwendungsfälle, einschließlich autonomer Fahrzeuge. Beispielsweise verfügen Tesla-Fahrzeuge über leistungsstarke Bordcomputer, die Daten mit geringer Latenz (fast in Echtzeit) für Daten verarbeiten können, die von Dutzenden von Fahrzeugperipheriesensoren erfasst werden. ermöglicht es dem Fahrzeug, zeitnah unabhängige Entscheidungen zu treffen.)

Andere fortschrittliche Technologien wie drahtlose medizinische Geräte und Sensoren verfügen jedoch nicht über die erforderliche Verarbeitungsleistung, um große Ströme komplexer Daten direkt zu verarbeiten.

Infolgedessen werden kleinere, modulare Rechenzentren bereitgestellt, um hyperlokale Datenspeicherungs- und -verarbeitungssysteme bereitzustellen. Laut CB Insights Market Sizing wird der globale Computermarkt bis 2023 34 Mrd. USD erreichen.

Diese Rechenzentren, die normalerweise die Größe eines Versandbehälters haben, befinden sich am Fuß der Mobilfunkmasten oder so nahe wie möglich an der Datenquelle.

Neben Transport und Gesundheitswesen werden diese modularen Rechenzentren in Branchen wie Fertigung, Landwirtschaft, Energie und Versorgung eingesetzt. Sie helfen auch Mobilfunknetzbetreibern (MNS), Inhalte schneller an Mobilfunkteilnehmer zu liefern, während viele Technologieunternehmen diese Systeme verwenden, um Inhalte näher an ihren Endbenutzern zu speichern (oder zwischenzuspeichern).

Vapor IO ist eines der Unternehmen, das Colocation-Services anbietet und kleine Rechenzentren auf der Basis von Mobilfunkmasten hostet. Das Unternehmen unterhält eine strategische Partnerschaft mit Crown Castle, dem größten Anbieter von drahtloser Infrastruktur in den USA.

Andere führende Rechenzentrumsunternehmen wie Edgemicro bieten Mikrodatenzentren an, die Mobilfunknetzbetreiber (MNCs) mit Content Providern (CPS) verbinden. Die Gründer von EdgeMicro stützen sich auf die Erfahrung von Führungskräften von Organisationen wie Schneider Electric, einem der größten Energieunternehmen in Europa, und CyrusOne, einem der größten und erfolgreichsten Anbieter von Rechenzentrumsdiensten in den USA.

Das Unternehmen hat kürzlich seine erste Produktionseinheit vorgestellt und plant, seine Colocation-Dienste an Inhaltsanbieter wie Netflix und Amazon zu verkaufen, um von einer verbesserten Geschwindigkeit und Zuverlässigkeit der Inhaltsbereitstellung zu profitieren. Diese Colocation-Services sind ideal für Unternehmen, die ihre Dateninfrastruktur besitzen, aber nicht verwalten möchten.

Kantenmikro

Und Startups sind nicht die einzigen auf dem Markt für Edge-Rechenzentren.

Große Unternehmen wie Schneider Electric arbeiten nicht nur mit Startups zusammen, sondern entwickeln auch eigene Produkte für Rechenzentren. Schneider bietet verschiedene vorgefertigte modulare Rechenzentren an, die sich ideal für eine Vielzahl von Branchen eignen, die hyperlokalen Computer- und Speicherplatz benötigen.

Huawei

Diese End-to-End-Lösungen integrieren Strom-, Kühlungs-, Brandbekämpfungs-, Beleuchtungs- und Steuerungssysteme in einem Paket. Sie sind für eine schnelle Bereitstellung, zuverlässige Leistung und Fernüberwachung ausgelegt.

Mega-Rechenzentren

Am anderen Ende des Spektrums befinden sich Mega-Rechenzentren - Rechenzentren mit einer Fläche von mindestens 1 Million Quadratmetern. Füße. Diese Einrichtungen sind groß genug, um die Anforderungen von Zehntausenden von Organisationen gleichzeitig zu erfüllen, und profitieren in hohem Maße von Skaleneffekten.

Während der Bau dieser Mega-Center teuer ist, sind die Kosten pro Quadratfuß viel höher als die Kosten eines durchschnittlichen Rechenzentrums.

Eines der größten Projekte ist ein Objekt mit einer Fläche von 17,4 Millionen Quadratmetern. ft. von Switch Communications entwickelt, das Unternehmen Gehäuse, Kühlung, Strom, Bandbreite und physische Sicherheit für ihre Server bietet.

Schalter

Neben diesem riesigen Citadel-Campus in Tahoe Reno verfügt das Unternehmen über ein Rechenzentrum mit einer Fläche von 3,5 Millionen Quadratmetern. ft in Las Vegas, 1,8 Millionen Quadratmeter. ft in Grand Rapids und eine Million Quadratmeter. Füße in Atlanta. Der Citadel-Campus ist laut der Website des Unternehmens das weltweit größte Colocation-Rechenzentrum.

Big Tech baut auch aktiv Mega-Rechenzentren in den USA mit Facebook, Microsoft und Apple - alles Gebäude, um den wachsenden Bedarf an Datenspeicherung zu decken.

Facebook baut beispielsweise ein Rechenzentrum mit einer Fläche von 2,5 Millionen Quadratmetern. ft. in Fort Worth, Texas, um personenbezogene Daten seines Benutzers zu verarbeiten und zu speichern. Es wurde angenommen, dass das Rechenzentrum nur 750.000 Quadratmeter einnehmen wird. Füße, aber das Social-Media-Unternehmen hat beschlossen, seine Größe zu verdreifachen.

Quelle: Facebook

Das neue Rechenzentrum wird etwa 1 Milliarde US-Dollar kosten und sich auf 150 Hektar Land befinden, um eine zukünftige Erweiterung zu ermöglichen. Im Mai 2017 wurden 440.000 m². Füße.

Eine der jüngsten Investitionen von Microsoft ist ein Rechenzentrum in West Des Moines, Iowa, das das Unternehmen 3,5 Milliarden US-Dollar gekostet hat. Zusammen nimmt dieser Rechenzentrumscluster 3,2 Millionen Quadratfuß Platz ein, und das größte Rechenzentrum nimmt 1,7 Millionen Quadratfuß ein. Dieses dedizierte Rechenzentrum namens Project Osmium befindet sich auf 200 Hektar Land und wird voraussichtlich bis 2022 fertiggestellt sein.

In den letzten Jahren hat sich Iowa aufgrund niedriger Energiepreise (einige der niedrigsten im Land) und des geringen Risikos von Naturkatastrophen zu einem beliebten Ziel für Rechenzentren entwickelt.

Apple baut in Iowa auch eine kleine Einrichtung mit einer Fläche von 400.000 Quadratmetern, die 1,3 Milliarden US-Dollar kosten wird.

Quelle: Apple Newsroom

Während einige Apple-Einrichtungen von Grund auf für die Verwaltung aller Inhalte gebaut wurden - App-Speicher, Musik-Streaming Service, iCloud-Speicher, Benutzerdaten, Apple hat eine 1,3 m² große Solarmodulanlage in Mesa, Arizona, umfunktioniert, die im August 2018 eröffnet wurde. Das neue Rechenzentrum wird dank eines nahe gelegenen Solarparks zu 100% mit grüner Energie betrieben.

Außerhalb der USA gehören zu den Regionen, in denen diese Mega-Rechenzentren angesiedelt waren, Nordeuropa, das aufgrund seiner kühlen Temperatur und Steuererleichterungen ein beliebtes Ziel für Giganten der Gebäudetechnik war.

Hohhot, China, in der Inneren Mongolei gelegen, hat auch eine günstige Lage für Mega-Rechenzentren, da es Zugang zu billiger lokaler Energie, kühlen Temperaturen und Universitäts-Talenten hat (mit der Inner Mongolia University).

Während große Rechenzentren in ganz China zu einem beliebten Thema geworden sind, ist die Region Innere Mongolei zu einer Drehscheibe für solche Entwicklungen geworden. China Telecom (10,7 Mio. SF), China Mobile (7,8 Mio. SF) und China Unicom (6,4 Mio. SF) haben Mega-Rechenzentren in der Region eingerichtet.

Quelle: Die weltweit führenden Rechenzentren

Innovation in Rechenzentren

Neben Rechenzentren sind neue Rechenzentrumsstrukturen, die unter Berücksichtigung der Umweltvorteile entwickelt wurden, ein weiterer aufkommender Trend.

Heutzutage experimentieren viele Unternehmen mit Rechenzentren, die im und um den Ozean arbeiten. Diese Strukturen nutzen ihre Umgebung und Ressourcen, um die Server auf natürliche Weise zu sehr geringen Kosten zu kühlen.

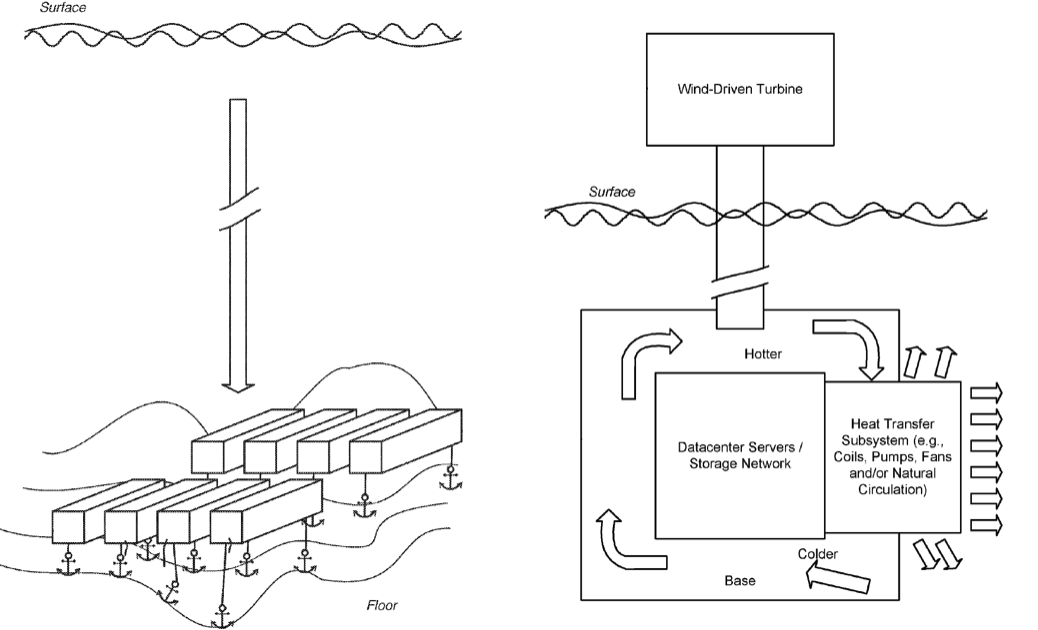

Eines der fortschrittlichsten Beispiele für die Verwendung des Ozeans mit freier Kühlung ist das Microsoft Project Natick-Projekt. Wie in einer 2014 eingereichten Patentanmeldung mit dem Titel „Submersible Data Center“ erwähnt, tauchte Microsoft ein kleines zylindrisches Rechenzentrum an der schottischen Küste unter Wasser.

Das Rechenzentrum nutzt 100% lokal erzeugten erneuerbaren Strom aus Wind- und Solarquellen an Land sowie Gezeiten und Wellen. Die Anlage nutzt den Ozean, um der Infrastruktur Wärme zu entziehen.

Quelle: Microsoft

Microsoft hat in diesem Projekt bereits große Fortschritte erzielt, die in Zukunft grünes Licht für den Ausbau von Rechenzentren im Ozean geben könnten.

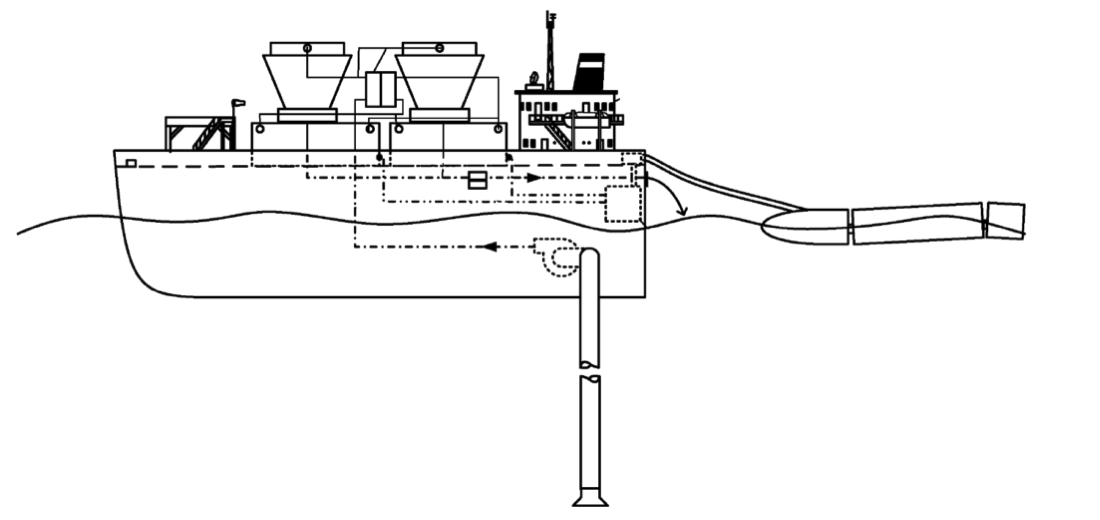

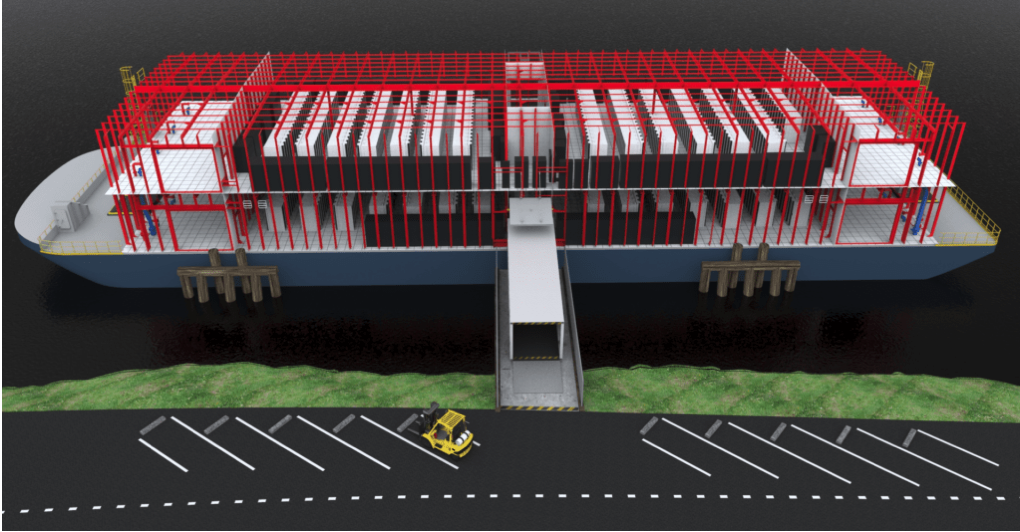

Google hat auch mit Rechenzentren im Ozean experimentiert. Im Jahr 2009 meldete das Unternehmen ein Patent für das Water Based Data Center an, das die Einrichtung von Rechenzentren an Bord schwimmender Lastkähne vorsieht.

Ähnlich wie bei Microsoft wird die Struktur das umgebende Wasser verwenden, um die Anlage auf natürliche Weise zu kühlen. Darüber hinaus kann der Lastkahn auch Energie aus Meeresströmungen erzeugen.

Obwohl Google nicht bekannt gab, ob diese Strukturen getestet wurden, wird angenommen, dass das Unternehmen bereits 2013 für einen schwimmenden Lastkahn in der Bucht von San Francisco verantwortlich war.

Der Start von Nautilus Data Technologies erfolgte mit einer sehr ähnlichen Idee. In den letzten Jahren hat das Unternehmen 58 Millionen US-Dollar gesammelt, um das Konzept dieses schwimmenden Rechenzentrums zum Leben zu erwecken.

Quelle: Geschäftsleiter

Das Unternehmen konzentriert sich weniger auf das Schiff selbst als vielmehr auf die Technologie, die zur Stromversorgung und Kühlung von Rechenzentren erforderlich ist. Die Hauptziele von Nautilus sind: Reduzierung der Rechenkosten, Reduzierung des Energieverbrauchs, Reduzierung des Wasserverbrauchs, Reduzierung der Luftverschmutzung und Reduzierung der Treibhausgasemissionen.

Energieeffizienz und Wirtschaftlichkeit

Derzeit entfallen 3% des gesamten Stromverbrauchs der Welt auf Rechenzentren, und dieser Prozentsatz wird nur noch zunehmen. Dieser Strom ist nicht immer „sauber“: Nach Angaben der Vereinten Nationen (UN) liefert der Informations- und Kommunikationstechnologiesektor (IKT), der stark von Rechenzentren angetrieben wird, die gleiche Menge an Treibhausgasen wie der Luftverkehrssektor mit Kraftstoff.

Während es den IKT gelungen ist, den Anstieg des Stromverbrauchs teilweise durch die Schließung alter, ineffizienter Rechenzentren einzudämmen, kann diese Strategie nur zu einem Anstieg des Internetverbrauchs und der Datenproduktion führen.

In Zukunft gibt es für Rechenzentren zwei Möglichkeiten, um Emissionen zu reduzieren: Verbesserung der Energieeffizienz im Rechenzentrum und Gewährleistung eines sauberen Energieverbrauchs.

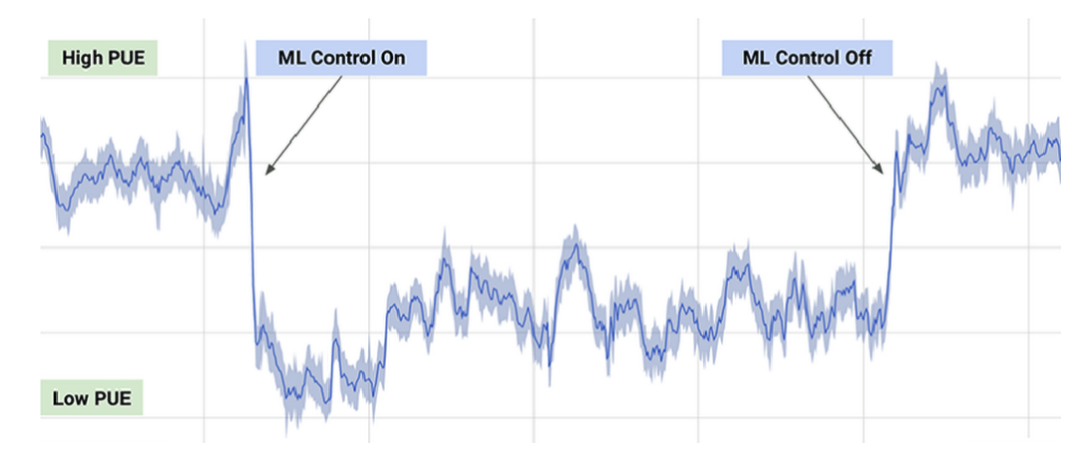

Verbrauchsreduzierung und Steigerung der Energieeffizienz

Im Jahr 2016 haben DeepMind und Google an einem KI-Empfehlungssystem gearbeitet, um die Rechenzentren von Google energieeffizienter zu gestalten. Der Fokus lag auf den kleinsten Verbesserungen: Schon kleine Änderungen reichten aus, um erhebliche Energieeinsparungen zu erzielen und Emissionen zu reduzieren. Nach Inkrafttreten der Empfehlungen erforderte ihre Umsetzung jedoch vom Betreiber zu viel Aufwand.

Rechenzentrumsbetreiber fragten, ob sie autonom implementiert werden könnten. Laut Google ist jedoch noch kein künstliches Intelligenzsystem bereit, die Kühl- und Heizprozesse im Rechenzentrum vollständig zu steuern.

Das aktuelle KI-Steuerungssystem von Google arbeitet mit bestimmten Aktionen, kann diese jedoch nur unter eingeschränkten Bedingungen ausführen, deren Priorität Sicherheit und Zuverlässigkeit sind. Nach Angaben des Unternehmens spart das neue System durchschnittlich bis zu 30% Energie.

Typischer PUE-Tag (Energieeffizienz) mit ein- und ausgeschaltetem ML.

Quelle: DeepMind

Google verwendete auch ein künstliches Intelligenzsystem, um die Effizienz eines Rechenzentrums im Mittleren Westen während der Tornadoüberwachung anzupassen. Während sich der menschliche Bediener auf die Vorbereitung auf den Sturm konzentrieren konnte, nutzte das KI-System die Tornado-Bedingungen - wie Luftdruckabfälle und Änderungen von Temperatur und Luftfeuchtigkeit - und kannte sie, um die Kühlsysteme des Rechenzentrums während eines Tornados auf maximale Effizienz abzustimmen. Im Winter passt sich das AI-Steuerungssystem dem Wetter an, um den zur Kühlung des Rechenzentrums erforderlichen Stromverbrauch zu senken.

Dieses Verfahren ist jedoch nicht ohne Nachteile. Lücken in der KI-Technologie erschweren es dem Zentrum, effektive Entscheidungen leicht zu treffen, und künstliche Intelligenz ist sehr schwer zu skalieren. Jedes Rechenzentrum von Google ist einzigartig und es ist schwierig, das KI-Tool (künstliche Intelligenz) gleichzeitig bereitzustellen.

Eine andere Möglichkeit, die Effizienz zu verbessern, besteht darin, die Art und Weise zu ändern, in der Sie überhitzte Teile des Rechenzentrums wie Server oder bestimmte Arten von Chips kühlen.

Eine solche Methode besteht darin, Flüssigkeit anstelle von Luft zum Kühlen von Teilen zu verwenden. Sundar Pichai, CEO von Google, sagte, die kürzlich veröffentlichten Chips des Unternehmens seien so leistungsstark, dass das Unternehmen sie in Flüssigkeit tauchen müsse, um sie im richtigen Maße abzukühlen.

Einige Rechenzentren experimentieren mit dem Eintauchen von Rechenzentren unter Wasser, um die Kühlung zu vereinfachen und die Energieeffizienz zu verbessern. Auf diese Weise haben Rechenzentren ständigen Zugriff auf natürlich kühles Tiefseewasser, sodass die Wärme von den Geräten an den umgebenden Ozean abgegeben wird. Da sich das Rechenzentrum vor jeder Küste befinden kann, stehen verschiedene grüne Energieanschlüsse zur Auswahl - beispielsweise das 40-Fuß-Microsoft-Projekt Natick, das vom Windnetz der Orkney-Inseln betrieben wird.

Kleinere Unterwasser-Rechenzentren haben den Vorteil, dass sie modular aufgebaut sein können. Dies vereinfacht ihren Einsatz im Vergleich zu neuen Zentren an Land.

Trotz dieser Vorteile sind einige Experten vorsichtig mit Unterwasser-Rechenzentren, da Überschwemmungen möglich sind. Da beim Abkühlen sauberes Wasser angesaugt und heißes Wasser in die umliegende Region abgegeben wird, können diese Rechenzentren das Meer wärmer machen und das lokale Meeresleben beeinträchtigen. Unterwasser-Rechenzentren wie Project Natick sind zwar so konzipiert, dass sie ohne menschliche Kontrolle betrieben werden können. Wenn jedoch Probleme auftreten, kann es schwierig sein, sie zu beheben.

In Zukunft können Rechenzentren auch zu sauberer Energie und Effizienz beitragen, indem sie einen Teil des von ihnen erzeugten Stroms recyceln. In mehreren Projekten wird bereits die Möglichkeit der Wiederverwendung von Wärme untersucht. Das nordische Rechenzentrum DigiPlex arbeitet mit dem Heizungs- und Kühlungslieferanten Stockholm Exergi zusammen, um ein Wärmerückgewinnungssystem zu entwickeln. Das Konzept dieser Lösung besteht darin, überschüssige Wärme im Rechenzentrum zu sammeln und an das lokale Fernwärmesystem zu senden, um möglicherweise bis zu 10.000 Stockholmer zu heizen.

Saubere Energie kaufen

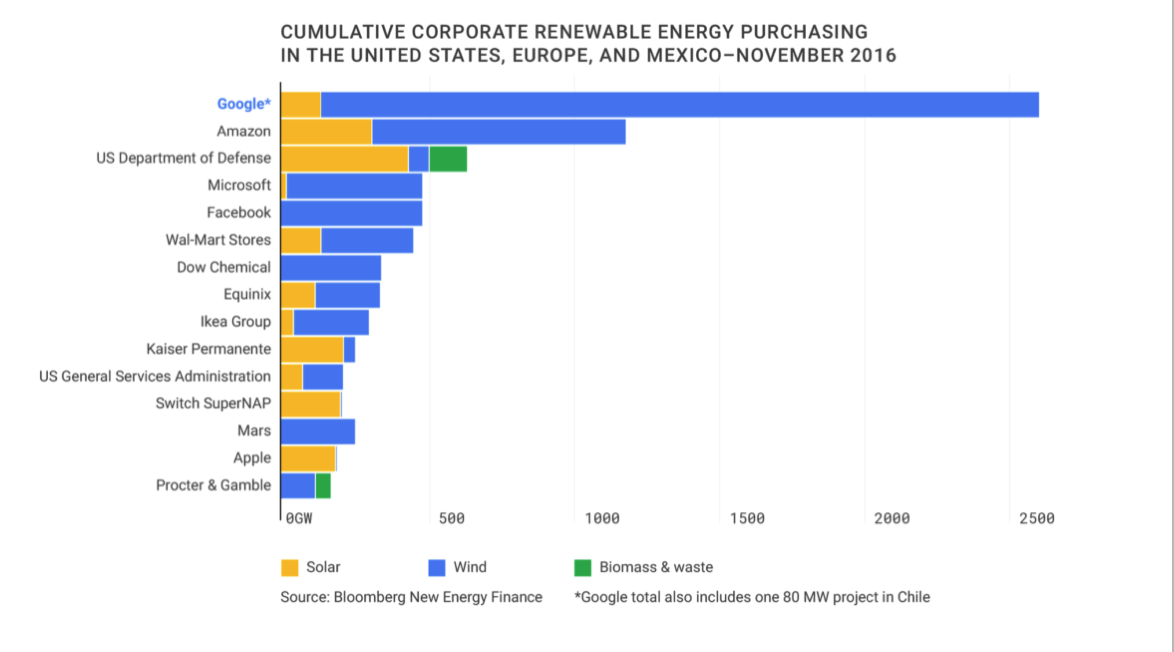

Laut IEA hat die IKT-Branche einige Fortschritte bei sauberer Energie gemacht und schließt derzeit fast die Hälfte aller Kaufverträge für erneuerbare Energien von Unternehmen ab.

Ab 2016 ist Google der weltweit größte Abnehmer von erneuerbarer Energie für Unternehmen.

Quelle: Google Sustainability

Im Dezember 2018 erwarb Facebook 200 MW Energie von einem Unternehmen, das Solarenergie produziert. In Singapur, wo die Landfläche begrenzt ist, hat Google Pläne zum Kauf von 60 MW Solardach angekündigt.

Gleichzeitig können große Unternehmen wie Google und Facebook, die über die Ressourcen verfügen, um große Mengen erneuerbarer Energie zu kaufen, für kleine Unternehmen, die möglicherweise keine großen Mengen an Energie benötigen, schwierig sein.

Eine weitere teurere Option zur Energieerzeugung ist MicroGrid: Installation einer unabhängigen Energiequelle in einem Rechenzentrum.

Ein Beispiel für eine solche Strategie sind Brennstoffzellen, wie sie das kürzlich börsennotierte Unternehmen Bloom Energy verkauft. Die Zellen nutzen Wasserstoff als Brennstoff zur Stromerzeugung. Obwohl diese alternativen Quellen häufig als Backup-Energie verwendet werden, kann sich das Rechenzentrum vollständig auf dieses System verlassen, um zu überleben, obwohl es eine wirtschaftlich teure Option ist.

Eine andere Möglichkeit, wie Rechenzentren saubere Energie untersuchen, ist die Verwendung erneuerbarer Energiequellen (REC), die eine bestimmte Menge sauberer Energie darstellen und normalerweise zum Ausgleich der vom Unternehmen verwendeten „schmutzigen Energie“ verwendet werden. Für jede Menge an schmutziger Energie, die produziert wird, repräsentiert REC die Produktion einer äquivalenten Menge sauberer Energie in der Welt. Diese zurückgewonnenen Mengen werden dann an den Markt für erneuerbare Energien zurückgekauft.

Es gibt jedoch bestimmte Probleme mit dem REC-Modell. Einerseits kompensiert REC nur schmutzige Energie - dies bedeutet nicht, dass das Rechenzentrum mit sauberer Energie betrieben wird. Obwohl die REC-Methode im Allgemeinen einfacher ist, als verfügbare Quellen zu finden, die genug Energie liefern können, um die Anforderungen des Rechenzentrums zu erfüllen. Der Nachteil ist, dass die Methode im Allgemeinen nicht für kleine Unternehmen verfügbar ist, die nicht immer über Kapital verfügen, um sich auf Schwankungen in einer Solar- oder Windkraftanlage zu stützen.

In Zukunft wird die Technologie eine enge Zusammenarbeit zwischen kleinen Produzenten und Käufern ermöglichen. Marktmodelle und Portfolios für erneuerbare Energien (ähnlich denen von Investmentfonds) entstehen, um die Schwankungen bei erneuerbaren Energien zu bewerten und zu quantifizieren.

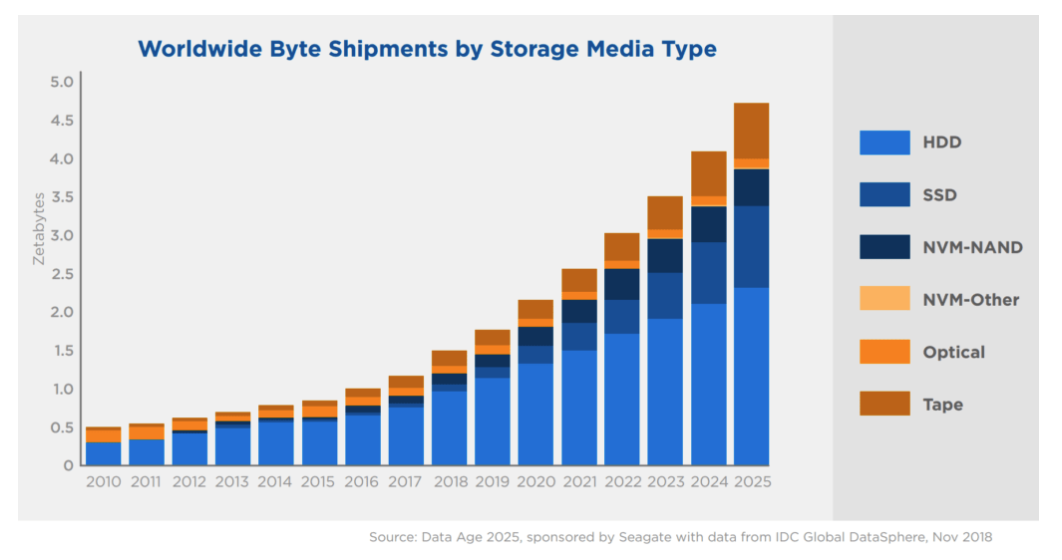

(SSD)

SSDs oder SSDs sind eine Art Speichergerät, das das Lesen und Schreiben von Daten unterstützt. Diese Geräte können Daten ohne Strom speichern - dies wird als permanenter Speicher bezeichnet. Dies steht im Gegensatz zu temporären Formen der Datenspeicherung wie dem Direktzugriffsspeicher (RAM), in dem Informationen nur gespeichert werden, während das Gerät ausgeführt wird.

SSDs konkurrieren mit HDDs, einer anderen Form des Massenspeichers. Der Hauptunterschied zwischen SSDs und HDDs besteht darin, dass SSDs ohne bewegliche Teile arbeiten. Dadurch sind SSDs langlebiger und leichter.

SSDs bleiben jedoch teurer als herkömmliche HDDs - ein Trend, der sich wahrscheinlich ohne Durchbruch bei der Herstellung von Solid-State-Laufwerken fortsetzen wird.

Quelle: Silicon Power Blog

Obwohl Solid-State-Laufwerke zum Standard für Laptops, Smartphones und andere Geräte mit dünnem Profil geworden sind, sind sie weniger praktisch und daher in großen Rechenzentren aufgrund ihres höheren Preises weniger verbreitet.

Quelle: Seagate & IDC

Laut IDC werden bis Ende 2025 mehr als 80% der Speicherkapazität des Unternehmens in Form von Festplatten verbleiben. Nach 2025 werden SSDs möglicherweise zum bevorzugten Speichermedium für Unternehmen und ihre Rechenzentren.

Da Solid-State-Laufwerke in der Unterhaltungselektronik und in IoT-Geräten immer häufiger eingesetzt werden, kann eine steigende Nachfrage zu einem höheren Angebot und letztendlich zu niedrigeren Kosten führen.

Kühlhaus

Im Gegensatz zu neueren SSDs werden im Kühlraum viele ältere Technologien wie CD-Rs und Magnetbänder verwendet, um die Daten so wenig wie möglich mit Strom zu versorgen.

Der kalte Speicher benötigt viel länger für den Zugriff auf Daten als der heiße Speicher (z. B. SSD). In solchen Systemen sollten nur selten verwendete Daten gespeichert werden.

"Hot" Clouds funktionieren auf SSDs und Hybrid-Laufwerken und bieten den schnellsten Zugriff auf Informationen. Kühlraum ist eine wirtschaftlichere und langsamere Lösung. In "Cold Clouds" speichern sie Informationen, die für eine sofortige Einarbeitung nicht erforderlich sind. Nach einer Anfrage können Daten von einigen Minuten bis zu mehreren zehn Stunden heruntergeladen werden.

Der Temperaturunterschied in den Rechenzentren ist buchstäblich: Je schneller die Cloud, desto mehr Wärme erzeugt das Gerät.

Die weltweit größten Technologieunternehmen wie Facebook, Google und Amazon verwenden jedoch Kühlräume, um selbst die detailliertesten Benutzerdaten zu speichern. Cloud-Anbieter wie Amazon, Microsoft und Google bieten diese Dienste auch Kunden an, die Daten zu niedrigen Preisen speichern möchten.

Laut dem Marktkalibrierungs-Tool von CB Insights wird der Kühlhausmarkt bis 2025 voraussichtlich fast 213 Mrd. USD erreichen.

habrastorage.org/webt/cr/cc/t-/crcct-u3vtckequtnd0eazlwkqk.png

Quelle: IBM

Kein Unternehmen möchte bei der Datenerfassung hinter der Kurve stehen. Die meisten Organisationen argumentieren, dass es heute am besten ist, so viele Daten wie möglich zu sammeln, auch wenn sie noch nicht entschieden haben, wie sie morgen verwendet werden sollen.

Diese Art nicht verwendeter Daten wird als dunkle Daten bezeichnet. Dies sind Daten, die gesammelt, verarbeitet und gespeichert werden, aber normalerweise nicht für bestimmte Zwecke verwendet werden. IBM schätzt, dass ungefähr 90% der aus dem Internet gesammelten Sensordaten niemals verwendet werden.

In Zukunft gibt es möglicherweise effektivere Möglichkeiten, um die Gesamtmenge der gesammelten und gespeicherten dunklen Daten zu reduzieren. Aber auch mit der Entwicklung der künstlichen Intelligenz und des maschinellen Lernens sind Unternehmen heutzutage immer noch daran interessiert, so viele Daten wie möglich zu sammeln und zu speichern, um diese Daten in Zukunft nutzen zu können.

In absehbarer Zeit ermöglicht es der beste Kühlraum daher, Daten zum niedrigsten Preis zu speichern. Dieser Trend wird sich fortsetzen, wenn Benutzer mehr Daten generieren und Organisationen diese sammeln.

Andere Formen der Datenspeicherung

Neben Solid-State-Laufwerken, Festplatten, CDs und Magnetbändern entstehen eine Reihe neuer Speichertechnologien, die mehr Kapazität pro Speichereinheit versprechen.

Eine der vielversprechenden Technologien ist die thermomagnetische Aufzeichnung (auch thermomagnetische Aufzeichnung) oder HAMR. HAMR erhöht die Datenmenge, die auf Geräten wie Festplatten gespeichert werden kann, erheblich, indem die Oberfläche der Disc während der Aufnahme mit einem hochpräzisen Laser erwärmt wird. Dies ermöglicht eine genauere und stabilere Datenaufzeichnung, wodurch die Speicherkapazität erhöht wird.

Es wird erwartet, dass diese Technologie bis 2020 die Produktion von bis zu 20 TB Festplatten auf einem 3,5-Zoll-Laufwerk ermöglicht und in Zukunft die Kapazität jährlich um 30% bis 40% erhöht. Seagate hat bereits ein 3,5-Zoll-Laufwerk mit 16 TB entwickelt, das im Dezember 2018 angekündigt wurde.

In den letzten zehn Jahren hat Seagate diese HAMR-Technologie aktiv patentiert. Im Jahr 2017 meldete das Unternehmen eine Rekordzahl von Patenten im Zusammenhang mit dieser Technologie an.

(Hinweis: Zwischen der Einreichung von Patenten und der Veröffentlichung liegt eine Verzögerung von 12 bis 18 Monaten, sodass 2018 eine noch größere Anzahl von Patenten HAMR zu sehen sein könnte.)

Ein wenig Werbung :)

Vielen Dank für Ihren Aufenthalt bei uns. Gefällt dir unser Artikel? Möchten Sie weitere interessante Inhalte sehen? Unterstützen Sie uns, indem Sie eine Bestellung aufgeben oder Freunden Cloud-VPS für Entwickler ab 4,99 US-Dollar empfehlen, ein einzigartiges Analogon von Einstiegsservern, das wir für Sie erfunden haben: Die ganze Wahrheit über VPS (KVM) E5-2697 v3 (6 Kerne) 10 GB DDR4 480 GB SSD 1 Gbit / s ab 19 $ oder wie teilt man den Server richtig? (Optionen sind mit RAID1 und RAID10, bis zu 24 Kernen und bis zu 40 GB DDR4 verfügbar).

Dell R730xd ist im Equinix Tier IV-Rechenzentrum in Amsterdam 2x billiger? Nur wir haben 2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2,6 GHz 14C 64 GB DDR4 4 x 960 GB SSD 1 Gbit / s 100 TV von 199 US-Dollar in den Niederlanden! Dell R420 - 2x E5-2430 2,2 GHz 6C 128 GB DDR3 2x960 GB SSD 1 Gbit / s 100 TB - ab 99 US-Dollar! Lesen über . c Dell R730xd 5-2650 v4 9000 ?