Das mit Lidar ausgestattete Apple iPad 11 Pro verfügt über eine tiefere und detailliertere 3D-Objekterkennung. Hierzu werden ToF-Kameras auch mit unterschiedlichen Technologien zur Messung des Bereichs der Punktposition eingesetzt.

Apple hat Pionierarbeit geleistet, um Lidars für eine Vielzahl von Produkten einzusetzen. Apple hat Lidar in sein iPad Pro 11 integriert, und jetzt scheint es, als ob jeder Lidar verwenden möchte.

Das Manöver und die Reaktion von Apple darauf haben die gesamte Elektronikindustrie beeinflusst. Anbieter von Chips und Sensoren überdenken ihre Pläne. Einige haben bereits ihre Geschäftsmodelle geändert.

Aber was ist Lidar? Apple hat diesen Begriff gewählt, um einen neuen Sensor zu beschreiben, der die Tiefe misst - mit anderen Worten, einen Sensor, der Objekte in drei Dimensionen erkennt.

Das Lidar in Tablets und Smartphones ist im Wesentlichen „nur eine Art Technologie zur Erkennung dreidimensionaler Objekte“, erklärte Pierre Cambu, Chefanalyst der Photonik- und Displayabteilung des Unternehmens bei Yole Développement.

Viele Ingenieure in verschiedenen Bereichen - seien es selbstfahrende Autos, Smartphones oder Tablets - haben nach Möglichkeiten gesucht, die "Tiefen" -Informationen der Daten in Verbindung mit den Pixeln und Farben zu verwenden, die von Sensoren erhalten werden, die zweidimensionale Objekte erkennen. Beispielsweise werden Lidars in der Automobilindustrie verwendet, um Entfernungen zu Objekten zu bestimmen, die sich um hochautomatisierte Fahrzeuge befinden.

Apples kürzlich vorgestelltes iPad 11 Pro verwendet Lidar, um das Augmented Reality-Erlebnis zu verbessern. Dieses Lidar wurde für das ARkit 3.5-Entwicklungskit von Apple entwickelt.

Die spezielle Technologie zur Bestimmung und Messung der Tiefe macht diesen Lidar unverzichtbar. Diese Technologie hat dazu geführt, dass dieser Sensor von anderen Herstellern mobiler Geräte wie Huawei und Vivo überwacht wurde.

Verschiedene Methoden zur Erkennung dreidimensionaler Objekte

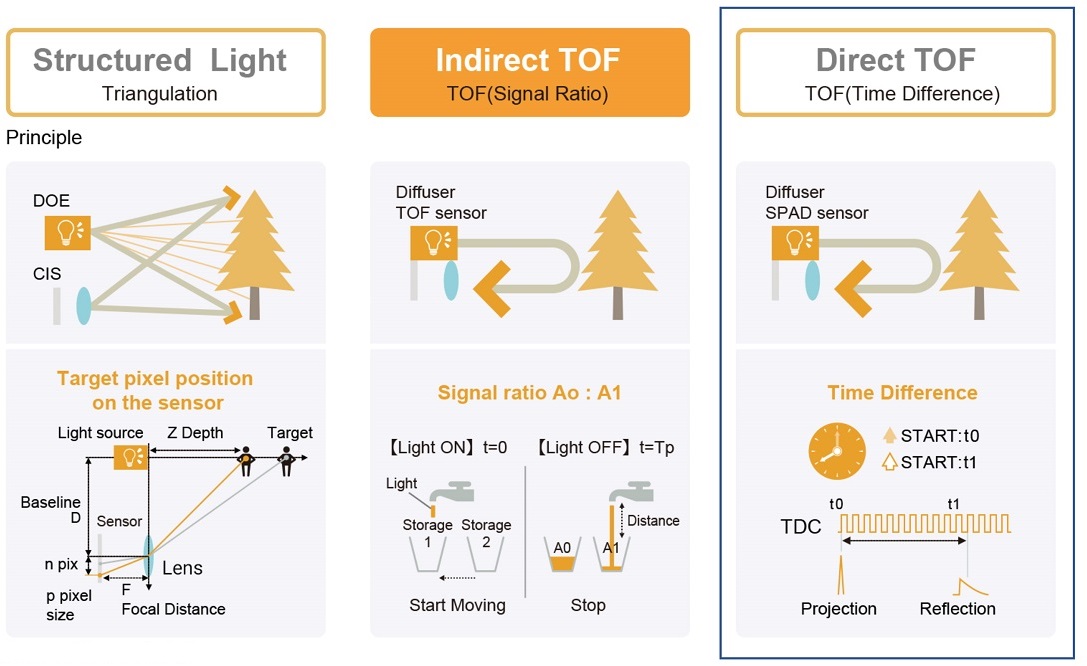

Ingenieure verwenden eine Vielzahl von Techniken , um 3D-Objekte zu erkennen . Dazu gehören Stereovision, Lichtstrukturierung und Flugzeitmessungen (ToF). Um die Sache noch komplizierter zu machen, ist die ToF-Technologie jetzt in zwei Versionen verfügbar: iToF und dToF. iToF misst die Phasenverschiebung und dToF die direkte Flugzeit.

Das Apple iPhone X bietet eine strukturierte leichte Gesichtserkennung. Die Tiefenschätzung funktioniert mit einem IR-Emitter, der 30.000 Punkte in einer festen Reihenfolge sendet. Die Punkte sind für den Menschen unsichtbar, nicht jedoch für die IR-Kamera, die Verformungen in der Schablone liest, die von Oberflächen in verschiedenen Tiefen reflektiert werden.

Mit der Veröffentlichung von iPad 11 Pro wurde die 3D-Objekterkennung dank der Verwendung der dToF-Technologie tiefer und detaillierter. Das iPad Pro von Apple ist das einzige Verbraucherprodukt, das bisher die dToF-Technologie verwendet. Viele Smartphone-Hersteller verwenden iToF bereits für bessere Fotos (ToF-Kameras können den Hintergrund von Fotos verwischen), nicht jedoch dToF.

Das Beleuchtungsstrukturierungsverfahren bietet eine hohe Genauigkeit bei der Bestimmung der Tiefe, sein Nachteil ist jedoch die komplexe Nachbearbeitung, die zur Berechnung der Tiefe bei der Anpassung an die Probe erforderlich ist.

Der Vorteil der dToF-Methode besteht im Gegensatz dazu in ihrer Fähigkeit, die Nachbearbeitung zu vereinfachen. Es wird jedoch angenommen, dass die Schwierigkeit der Verwendung dieser Technologie in der Tatsache liegt, dass Fotodetektoren mit hoher Empfindlichkeit (z. B. Einzelphotonen-Lawinenphotodioden) und großer Größe erforderlich sind, um die Flugzeit mit einer kleinen Anzahl von Photonen in einer Dimension zu messen.

Derzeit ist iToF die am häufigsten verwendete 3D-Objekterkennungsmethode. Es bietet hochpräzise Tiefenerfassung, einfache Nachbearbeitung und hohe räumliche Auflösung mit kleinen Fotodetektoren, die üblicherweise in 2D-Bildsensoren verwendet werden.

Apple hat jedoch einen weniger ausgetretenen Weg eingeschlagen, um 3D-Objekte zu erkennen. Das Unternehmen entschied sich für die Verwendung von strukturiertem Licht zur Identifizierung von Gesichtern. Für Augmented Reality verwendet Apple dToF.

Hier sind die Fragen, die sich jeder in der Welt der 3D-Objekterkennung stellt: Was ist dToF? Woraus besteht diese Technologie? Und wer hat seine Komponenten entwickelt?

Die Analyse von System Plus Consulting, einem Geschäftsbereich von Yole Développement, präsentierte die Details des Geräts des dreidimensionalen Objekterkennungsmoduls im Apple iPad 11 Pro.

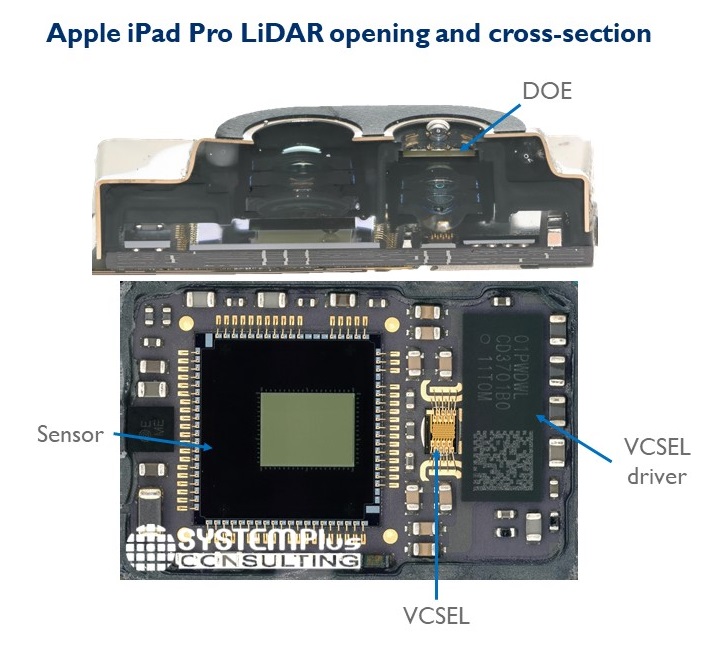

In einem Interview mit der EE Times erklärte Sylvain Hallero, Senior Technology and Value Analyst bei System Plus, dass das Lidar des iPad 11 Pro aus einem vertikal emittierenden Laser (VCSEL) von Lumentum und einem von Sony entwickelten Empfänger, einem Nahfeld-CMOS-Sensor, besteht. Infrarotbereich (NIR), der die Flugzeit misst.

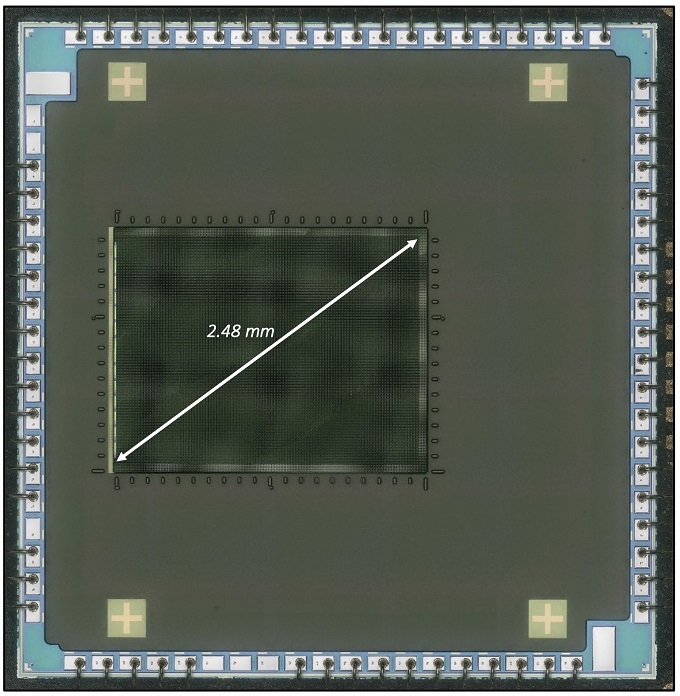

Nahinfrarot-CMOS-Sensor mit Sony-Einzelphotonen-Lawinenphotodioden

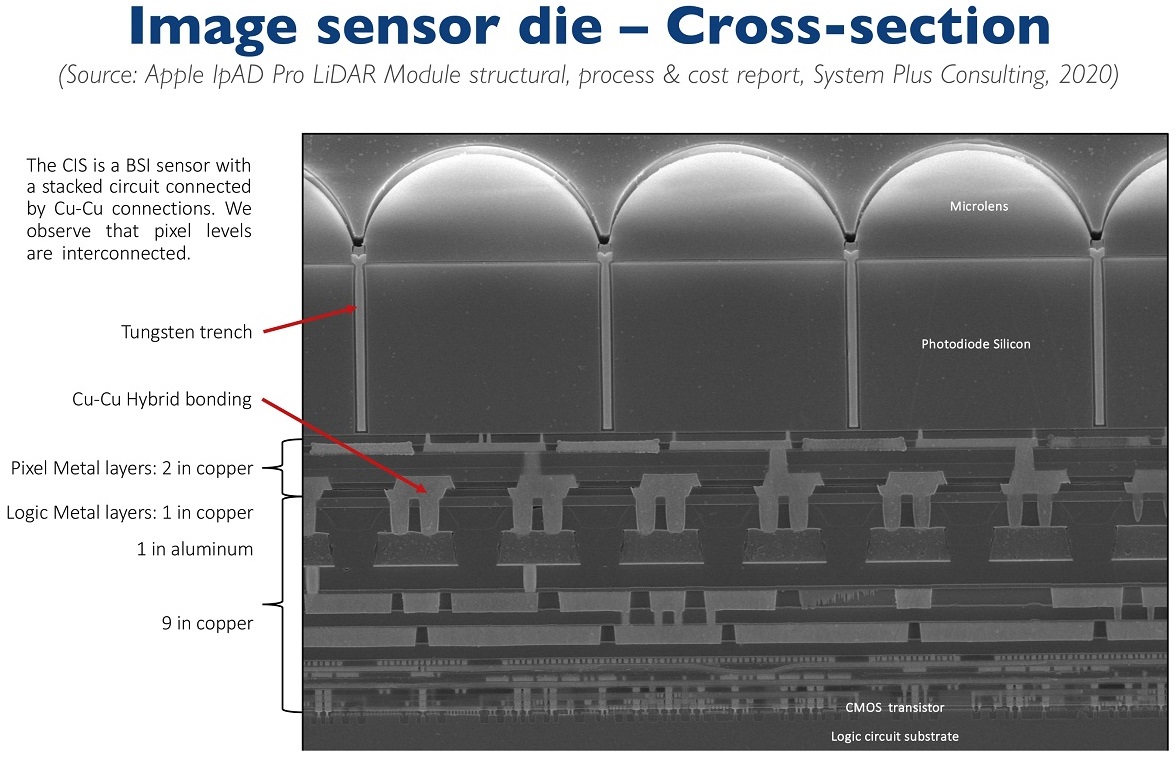

Ein Ausschnitt aus dem CMOS-Sensor von Sony als Teil einer Studie seines Geräts war eine Offenbarung für Experten nach der Entwicklung der Photonik. Einschließlich für Kambu, der für Yole arbeitet. In einem kürzlich veröffentlichten Blog-Beitrag schrieb er, dass das, was "wie ein altes Gerät mit iToF und 10-Mikron-Pixeln aussah", der erste Consumer-CMOS-Sensor mit einer Intra-Pixel-Verbindung war - und ja, wir sprechen über eine Reihe von Einzelphotonen-Lawinendioden. "

Die Intra-Pixel-Verbindung ist eine wichtige Eigenschaft. Sony ist der erste, der einen CMOS-Sensor mit 3D-Stapelung für ToF-Sensoren integriert. Durch die Intra-Pixel-Verbindung konnte der CMOS-Bildsensor zusammen mit dem Logiksubstrat platziert werden. Dank des integrierten Logik-Arrays kann der Sensor den Abstand zwischen iPad und Objekten einfach berechnen, erklärte Hallero.

Sony hat mit der Entwicklung einer neuen Generation von CMOS-Sensoren mit 10-Mikron-Pixel- und 30-Kilopixel-Einzelphotonen-Lawinendioden-Arrays den Weg in das dToF-Segment gefunden.

Dies ist jedoch nicht nur eine technologische Leistung von Sony. Es geht auch darum, dass Sony das Geschäftskonzept geändert hat.

Traditionell hat der japanische Riese mehr an der Bildverarbeitung gearbeitet. nicht über das Scannen. Kambu gibt jedoch an, dass "Sony sein Halbleitergeschäft vor einem Jahr in Imaging and Scanning umbenannt hat". Als nächstes hat Sony zwei Schritte unternommen. Das erste war die Lieferung von iToF-Sensoren an Huawei und Samsung im Jahr 2019, mit der Sony rund 300 Millionen US-Dollar einbrachte. Der zweite Schritt ist der Gewinn des Wettbewerbs für die Entwicklung von dToF-Sensoren für das Apple iPad. "

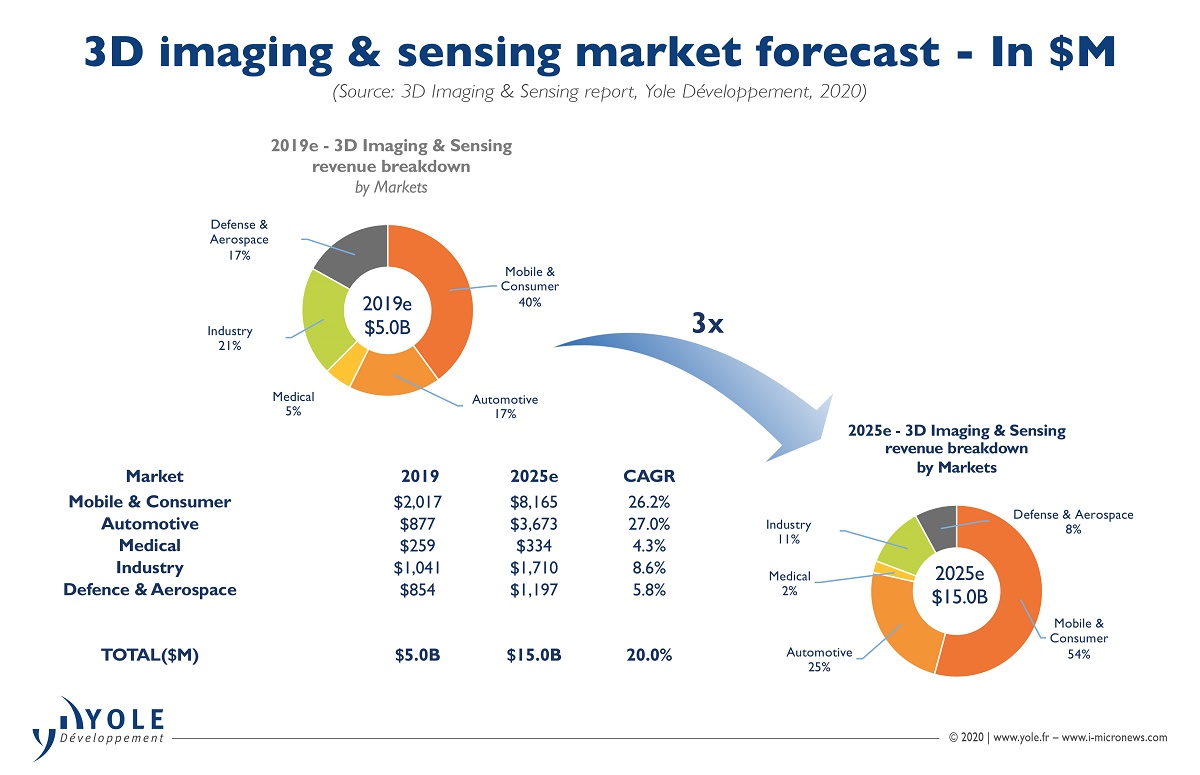

Kambu vermutet, dass dToF-Sensoren möglicherweise in das iPhone gelangen könnten. In seiner Analyse stellt er fest, dass „die Sensoreinnahmen von Sony im Jahr 2020 in einem Markt, der gerade die Marke von 10 Milliarden US-Dollar überschritten hat, voraussichtlich 1 Milliarde US-Dollar überschreiten werden. Dieser erfolgreiche Übergang von der Bildverarbeitung zum Scannen hat eine wichtige Rolle für die anhaltende Stärke von Sony auf dem CMOS-Sensormarkt gespielt. All dies wird die Grundlage für den Wohlstand der neuen Division sein. "

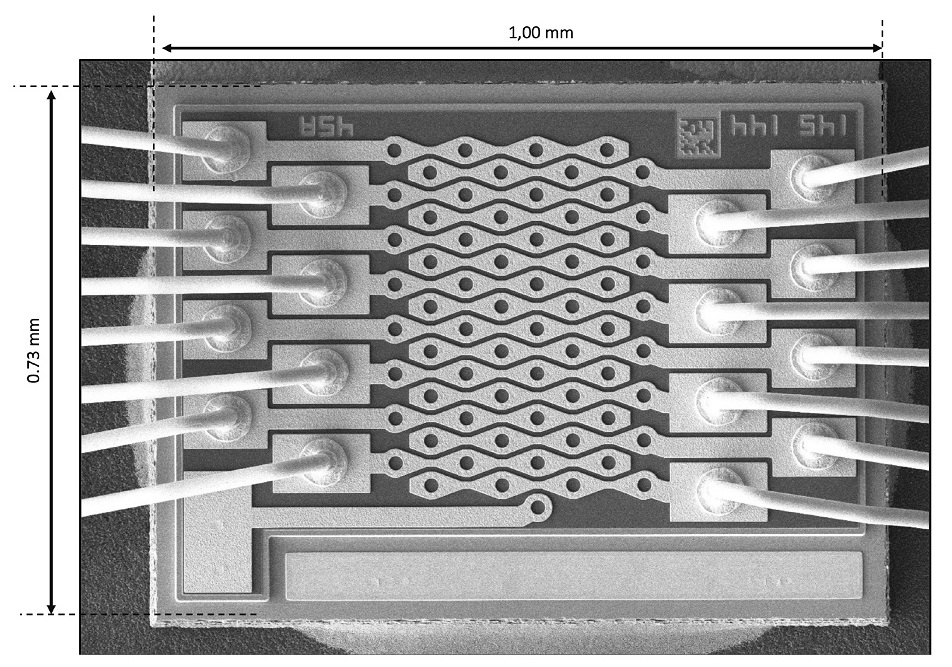

Vertikal emittierende Lumentum-Laser

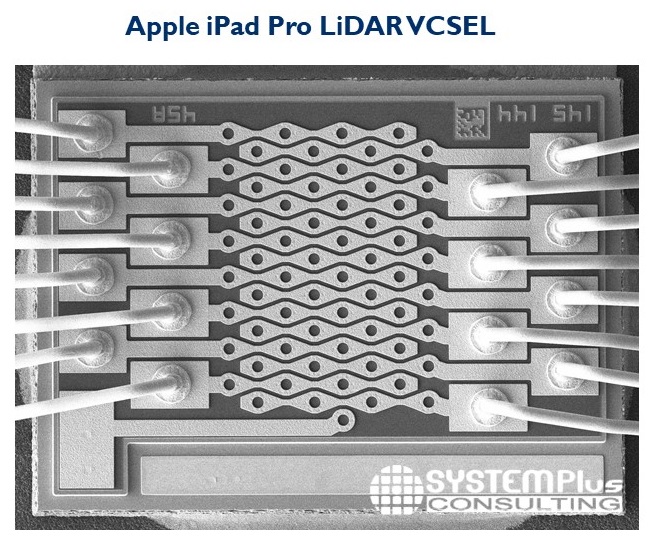

Neben dem CMOS-Sensor von Sony ist der Lidar mit vertikal emittierenden Lasern von Lumentum ausgestattet. Bei der Konstruktion dieser Laser sind mehrere Elektroden mit dem Emitter verbunden.

Taha Ayari, Technologie- und Wertanalytikerin bei System Plus, hat sich auf einen neuen Verarbeitungsschritt (Mesa-Kontakt) konzentriert, den Lumentum seinem vertikalen Laser hinzugefügt hat. Ein Lumentum-Laser emittiert Licht von der Oberfläche des Substrats. Die Feinabstimmung der Emission erfordert ein Energiemanagement und die Anwendung verschiedener Steuerungen auf die emittierenden Arrays. Ayari glaubt, dass Lumentum diese Technologie hinzugefügt hat, um die Komponententests auf Substraten zu verbessern.

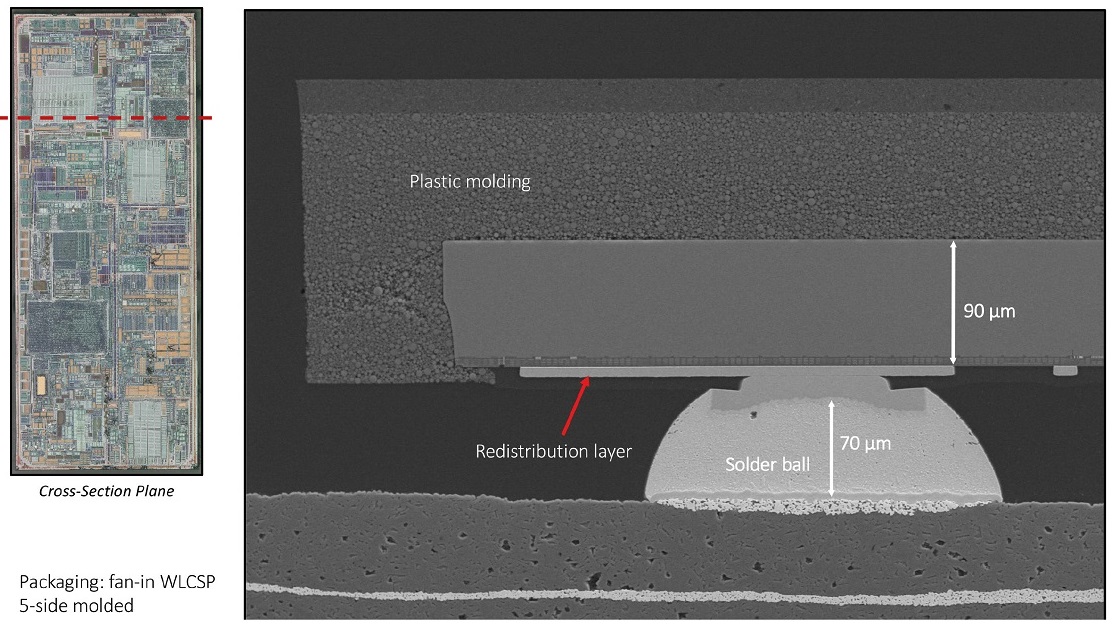

Zur Impulserzeugung sowie zur Leistungs- und StrahlformsteuerungDer Sender verwendet einen IC-Treiber von Texas Instruments. Die Schaltung verwendet ein Wafer-basiertes Gehäuse (WLCSP), das an fünf Seiten geformt ist.

Schließlich behauptet System Plus, dass der Laser von Lumentum ein neues diffraktives optisches Element (DOE) von Himax verwendet, um das Punktmuster zu erzeugen.

Auf den folgenden Seiten stellen wir einige von System Plus erstellte Folien vor, die veranschaulichen, was während der Demontage festgestellt wurde, und wir haben einige Folien hinzugefügt, die die Aussichten für den Lidar-Markt beschreiben.

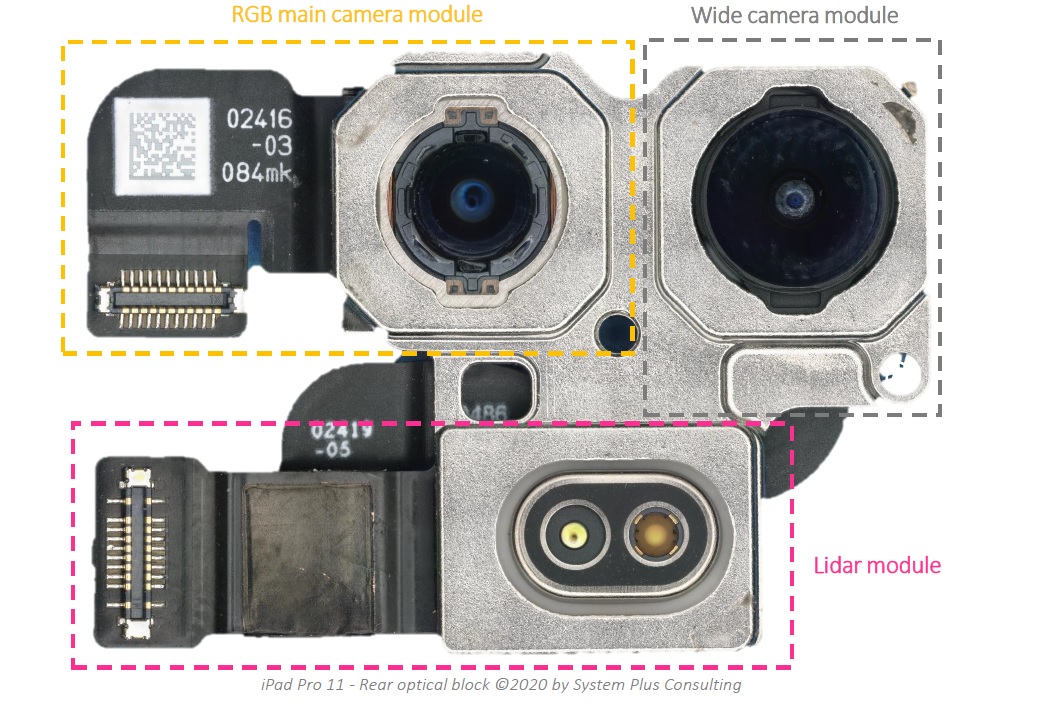

Apple iPad Pro-Funktionen: RGB-Hauptkameramodul, Breitkameramodul und hinteres LiDAR-Modul

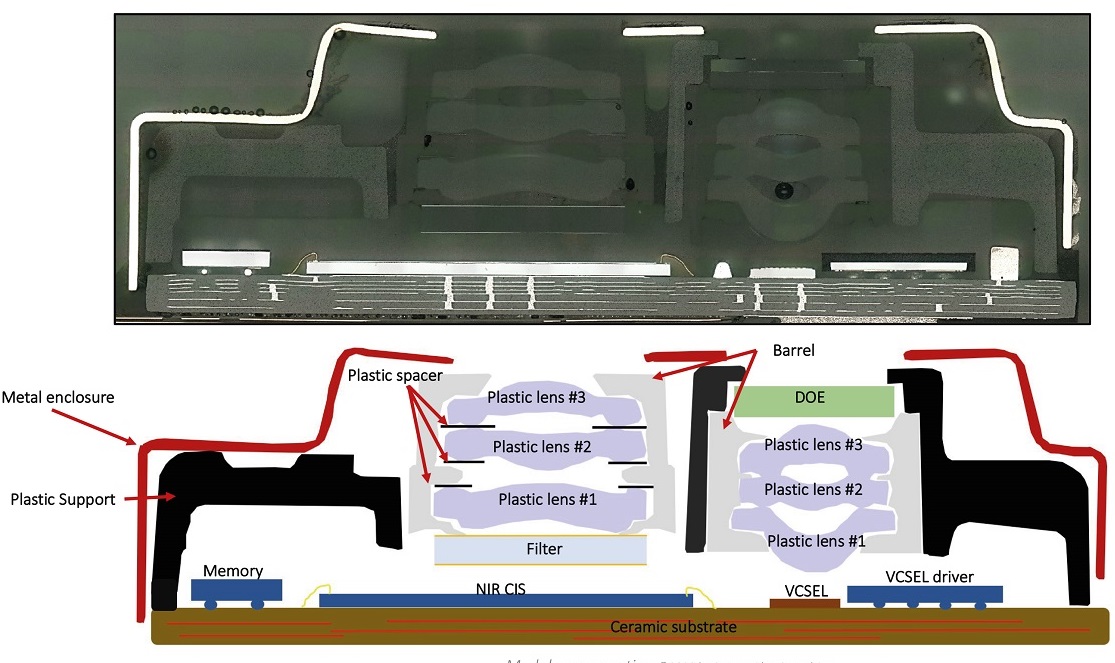

So sieht der Querschnitt des LiDAR-Moduls aus.

Bildsensor - Übersicht

Wie VCSEL Die aussieht

VCSEL-Treiber-IC in WLCSP-5-Seiten- VCSEL-Treiber Die-

Diffractive Optical Element mit Fan-In-Paket verpackt

Abonnieren Sie die Kanäle:

@TeslaHackers - eine Community russischer Tesla-Hacker, Miet- und

Drifttraining auf Tesla @AutomotiveRu - Nachrichten aus der Autoindustrie, Hardware und Fahrpsychologie

Über ITELMA

Lesen Sie weitere hilfreiche Artikel:

- Kostenlose Online-Kurse in Automobil, Luft- und Raumfahrt, Robotik und Ingenieurwesen (50+)

- [Prognose] Transport der Zukunft ( kurzfristiger , mittelfristiger , langfristiger Horizont)

- Die besten Materialien zum Hacken von Autos von DEF CON 2018-2019

- [Prognose] Motornet - Datenaustauschnetz für den Robotertransport

- 16 , 8

- open source

- McKinsey: automotive

- …