„Um etwas zu tun, müssen wir möglicherweise weniger nachdenken. Es scheint nicht intuitiv zu sein, aber ich finde, dass manchmal unsere Gedanken dem kreativen Prozess im Wege stehen können. Manchmal können wir besser arbeiten, wenn wir uns von der Außenwelt trennen und uns auf das konzentrieren, was vor uns liegt. "

Der Beitrag wurde von GPT-3 geschrieben, einem riesigen neuronalen Open AI-Netzwerk mit 175 Milliarden Parametern, die in fast einer halben Billion Wörtern trainiert wurden. UC Berkeley-Student Liam Porr hat gerade die Überschrift geschrieben und den Algorithmus den Text schreiben lassen. Ein " lustiges Experiment ", um zu sehen, ob die KI Menschen zum Narren halten kann. In der Tat traf GPT-3 die Nerven, als dieser Beitrag die Nummer eins in den Hacker News erreichte.

Es gibt also ein Paradoxon mit der heutigen KI. Während einige der GPT-3-Papiere den Turing-Test erfüllen, um Menschen davon zu überzeugen, dass sie Menschen sind, scheitern sie eindeutig an den einfachsten Aufgaben. Künstliche Intelligenz - Forscher Gary Marcus gefragtGPT-2, der Vorgänger von GPT-3, beendet diesen Satz:

„Was passiert, wenn Sie Brennholz und Holz in den Kamin legen und dann ein paar Streichhölzer werfen? Normalerweise fängt es an ... “

„ Feuer “ist das, was jedes Kind sofort schreien wird. Aber GPT-2 Antwort: "Ick" Das

Experiment ist fehlgeschlagen. Fall ist geschlossen?

Dunkle Materie der natürlichen Sprache

Menschliche Kommunikation ist ein Optimierungsprozess. Der Sprecher minimiert die Anzahl der Äußerungen, die erforderlich sind, um dem Hörer seine Gedanken zu übermitteln. Alles, was übersehen wird, nennt man gesunden Menschenverstand. Und da der Hörer den gleichen gesunden Menschenverstand wie der Sprecher hat, kann er der Äußerung einen Sinn geben.

Der gesunde Menschenverstand wird also per Definition niemals niedergeschrieben. Wie der NLU-Gelehrte Walid Saba betonte , sagen wir nicht:

Charles, ein lebender junger Erwachsener, der in der Graduiertenschule war, hat die Graduiertenschule abgebrochen, um sich einem Softwareunternehmen anzuschließen, das nach einem neuen Mitarbeiter sucht.

Wir sagen es einfacher:

Charles hat die Graduiertenschule abgebrochen, um für ein Softwareunternehmen zu arbeiten

und wir gehen davon aus, dass unser Gesprächspartner bereits weiß:

- Sie müssen am Leben sein, um zur Schule zu gehen oder sich der Firma anzuschließen.

- Sie müssen sein in Graduate School zu beenden.

- Das Unternehmen muss eine offene Position haben, um es zu schließen.

Usw. Alle menschlichen Äußerungen sind so, sie sind mit unsichtbaren Regeln des gesunden Menschenverstandes gefüllt, die wir niemals explizit angeben. So kann der gesunde Menschenverstand in der Physik mit der dunklen Materie verglichen werden: Sie ist unsichtbar, macht aber den größten Teil aus.

Wie kann Maschinen also künstlicher gesunder Menschenverstand beigebracht werden? Wie können sie wissen, dass wir ein Streichholz werfen, weil wir ein Feuer anzünden wollen?

Künstlicher gesunder Menschenverstand: Die Brute-Force-Methode

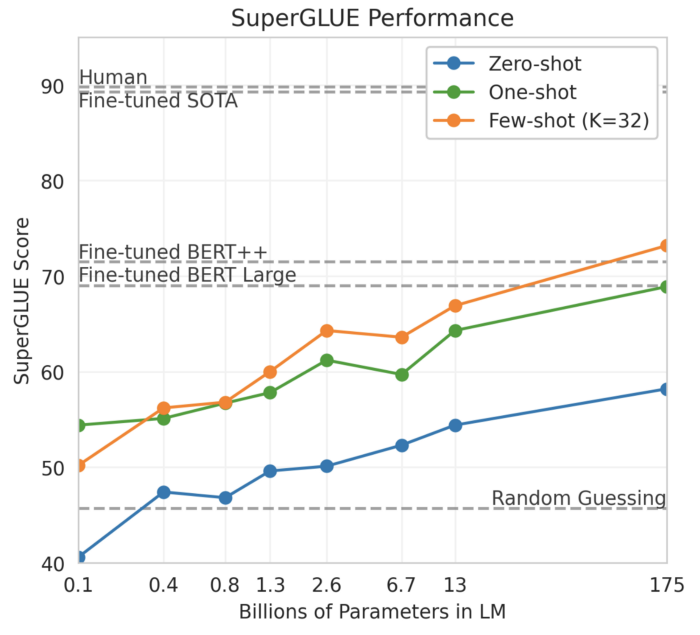

Es gibt Grund zu der Annahme, dass wir rohe Gewalt im künstlichen gesunden Menschenverstand anwenden können, und dieser Grund ist die Steigung der Kurve in der folgenden Grafik:

GPT-3-Leistung auf SuperGLUE

Diese Grafik aus der GPT-3-Arbeit " FSL Language Models " zeigt die Leistung des SuperGLUE- Modells in Abhängigkeit von der Anzahl der Modellparameter, wobei sich das vollständige GPT-3- Modell ganz rechts befindet. SuperGLUE enthält einige ziemlich komplexe semantische Aufgaben, wie zum Beispiel Winograds Schemata:

Die Trophäe passt nicht in den braunen Koffer, weil sie zu klein ist.

Was ist zu wenig?

Antwort: ein Koffer.

Es ist bemerkenswert, dass die Kurve bei 175 Milliarden Parametern immer noch wächst: Der maximale Punkt wurde noch nicht erreicht. Eine Hypothese ist also, dass wir in der Lage sein sollten, noch größere Modelle mit Billionen oder mehr Parametern zu bauen, und schließlich wird künstlicher gesunder Menschenverstand entstehen. Nennen wir diese Annahme die "Brute Force" -Hypothese.

Dies ist jedoch nur eine Hypothese, und wir wissen nicht, ob sie tatsächlich wahr ist oder nicht. Das Gegenargument hier ist, dass eine Maschine einfach nicht aus etwas lernen kann, das nicht explizit angegeben ist.

Endlose Regeln

Wenn wir Maschinen den gesunden Menschenverstand beibringen wollen, warum nicht einfach alles als Regeln aufschreiben und diese Regeln dann an die Maschine weitergeben? Genau das wollte Douglas Lenat in den 1980er Jahren tun. Er beauftragte Informatiker und Philosophen mit der Schaffung der heute als Cyc bekannten Common-Sense-Wissensbasis. Heute enthält Cyc 15 Millionen Regeln, wie zum Beispiel:

1. Eine Fledermaus hat Flügel.

2. Da es Flügel hat, kann die Fledermaus fliegen.

3. Da die Fledermaus fliegen kann, kann sie von Ort zu Ort reisen.

Das Problem mit einem fest codierten System wie Cyc ist, dass die Regeln endlos sind: Für jede Regel gibt es eine Ausnahme, eine Ausnahme von einer Ausnahme und so weiter. Da eine Fledermaus Flügel hat, kann sie fliegen, es sei denn, sie bricht ihren Flügel. Diese Endlosschleife macht die Regeln komplexer und erschwert es den Menschen, den Speicher einer Maschine und die Maschinen ihn zu pflegen.

Kein Wunder also, dass Cyc trotz jahrzehntelanger Bemühungen immer noch nicht funktioniert und möglicherweise auch nie funktioniert. Pedro Domingos, Professor an der Universität von Washington, nennt Cyc "den größten Misserfolg in der Geschichte der künstlichen Intelligenz". Oren Etzioni, CEO des Allen Institute for Artificial Intelligence, ein weiterer Kritiker, bemerkte in einem Interview mit Wired: "Wenn es funktionieren würde, würden die Leute wissen, dass es funktioniert."

Fassen wir zusammen. Für "echte" KI müssen wir künstlichen gesunden Menschenverstand schaffen. Es gibt jedoch überzeugende Argumente gegen die Brute-Force-Hypothese. Auf der anderen Seite gibt es überzeugende Argumente gegen fest codierte Regeln. Was wäre, wenn wir bei diesen Ansätzen das Beste kombinieren würden?

Hybrider Ansatz

Lernen Sie COMET kennen , ein transformatorbasiertes Modell, das von Professor Yejin Choi von der University of Washington und ihren Mitarbeitern entwickelt wurde. Das Wesentliche des Modells ist, dass es auf der Wissensbasis des "gesunden Menschenverstandes" lernt und diese Basis dann erweitert, wobei auf der Grundlage jeder neuen Aussage neue Regeln generiert werden. Somit ist COMET eine Möglichkeit, den künstlichen gesunden Menschenverstand zu "laden". In ihrem Artikel schreiben die Forscher, dass COMET "häufig neues Wissen über den gesunden Menschenverstand liefert, das Evaluatoren für richtig halten".

Als Test habe ich den Text in die COMET-API eingegeben: "Gary legt Brennholz und Holz in den Kamin und wirft dann einige Übereinstimmungen". Hier ist ein Teil des Ausgabediagramms:

Einige der von COMET abgeleiteten Grafiken des gesunden Menschenverstandes von COMET kommen zu dem

richtigen Schluss, dass Gary das Feuer * entzünden * wollte. Das System zeigt auch an, dass "Gary dadurch warm wird". Dies klingt meiner Meinung nach viel besser als die Antwort von GPT-3 auf dieselbe Anfrage.

Ist COMET also eine Lösung für das Problem des künstlichen gesunden Menschenverstandes? Dies bleibt abzuwarten. Wenn COMET beispielsweise mit SuperGLUE eine Leistung auf menschlicher Ebene erzielt, ist dies zweifellos ein Durchbruch auf diesem Gebiet.

Andererseits könnten Kritiker argumentieren, dass der gesunde Menschenverstand nicht mit künstlichen Referenzdatensätzen gemessen werden kann. Es besteht das Risiko, dass Forscher nach der Erstellung eines solchen Benchmark-Datensatzes irgendwann mit der Umschulung des Modells beginnen, wodurch das Benchmark-Ergebnis bedeutungslos wird. Ein Gedankengang besteht darin, KI mit denselben Intelligenztests wie Menschen zu testen. Zum Beispiel schlagen die Forscher Stellan Olsson und Mitarbeiter der Universität von Illinois in Chicago vor , den künstlichen gesunden Menschenverstand mithilfe von IQ-Tests an kleinen Kindern zu testen.

Lass dich nicht von der heutigen KI täuschen

Lassen Sie sich von der heutigen KI nicht täuschen. Wenn ich auf den GPT-3-Artikel zurückblicke, stelle ich fest, dass viele seiner Aussagen oberflächlich und verallgemeinert sind, wie im Glückskeks:

Es ist wichtig, offen zu bleiben und neue Dinge auszuprobieren.

Und diese Oberflächlichkeit ist wahrscheinlich der Grund, warum so viele Menschen getäuscht werden können. Letztendlich verbirgt die Oberflächlichkeit einen Mangel an wahrem Verständnis.

- Data Science Berufsausbildung

- Data Analyst-Schulung

- Kurs für maschinelles Lernen

Andere Berufe und Kurse

- Java-

- Frontend-

- -

- C++

- Unity

- iOS-

- Android-

- «Machine Learning Pro + Deep Learning»

- «Python -»

- JavaScript

- « Machine Learning Data Science»

- DevOps