Das Echtzeit-Rendering für die virtuelle Realität stellt eine einzigartige Reihe von Herausforderungen dar. Die wichtigsten sind die Notwendigkeit, fotorealistische Effekte zu unterstützen, hohe Auflösungen zu erzielen und die Bildwiederholfrequenz zu erhöhen. Um diesen Herausforderungen zu begegnen , entwickelten die Forscher von Facebook Reality Labs DeepFocus , eine Rendering-Engine, die wir im Dezember 2018 eingeführt haben. Es verwendet KI, um ultrarealistische Grafiken in Geräten mit variabler Brennweite zu erstellen. Auf der diesjährigen SIGGRAPH Virtual Conference präsentierten wir eine Weiterentwicklung dieser Arbeit und eröffneten damit einen neuen Meilenstein auf unserem Weg zu zukünftigen hochauflösenden Displays für VR.

Unser technischer Artikel für SIGGRAPH mit dem Titel " Neuronales Supersampling für Echtzeit-Rendering " bietet eine Lösung für maschinelles Lernen, die eingehende Bilder mit niedriger Auflösung in hochauflösende Bilder für Echtzeit-Rendering konvertiert. Dieser Upsampling- Prozess verwendet neuronale Netze, die auf Szenenstatistiken trainiert sind, um genaue Details wiederherzustellen, während die Rechenkosten für das Rendern dieser Details in Echtzeitanwendungen reduziert werden.

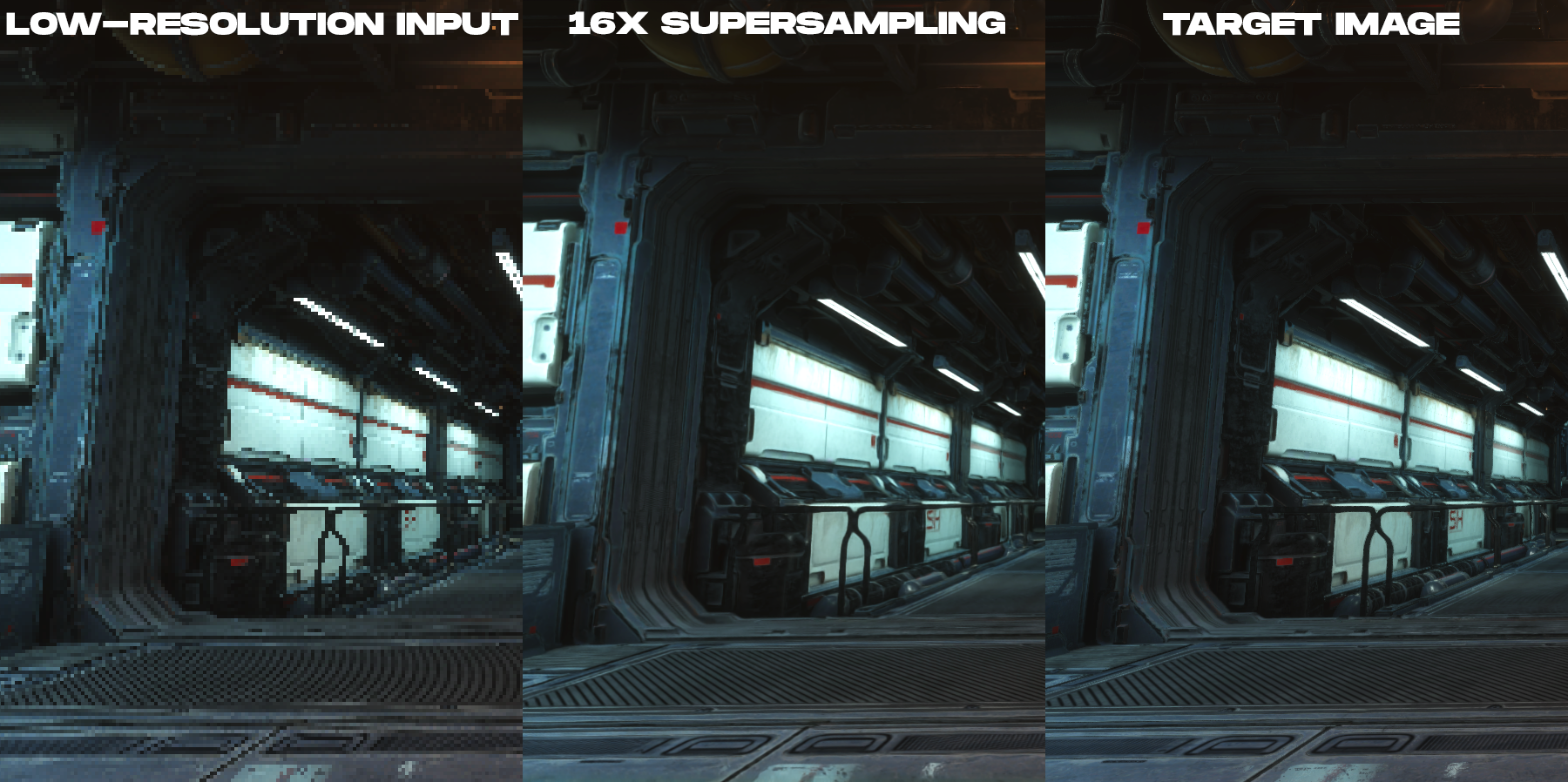

Unsere Lösung ist eine vorab trainierte Supersampling-Technik, die ein 16-faches Supersampling von Inhalten für das Rendern mit hoher räumlicher und zeitlicher Genauigkeit erzielt und frühere Arbeiten bei weitem übertrifft.

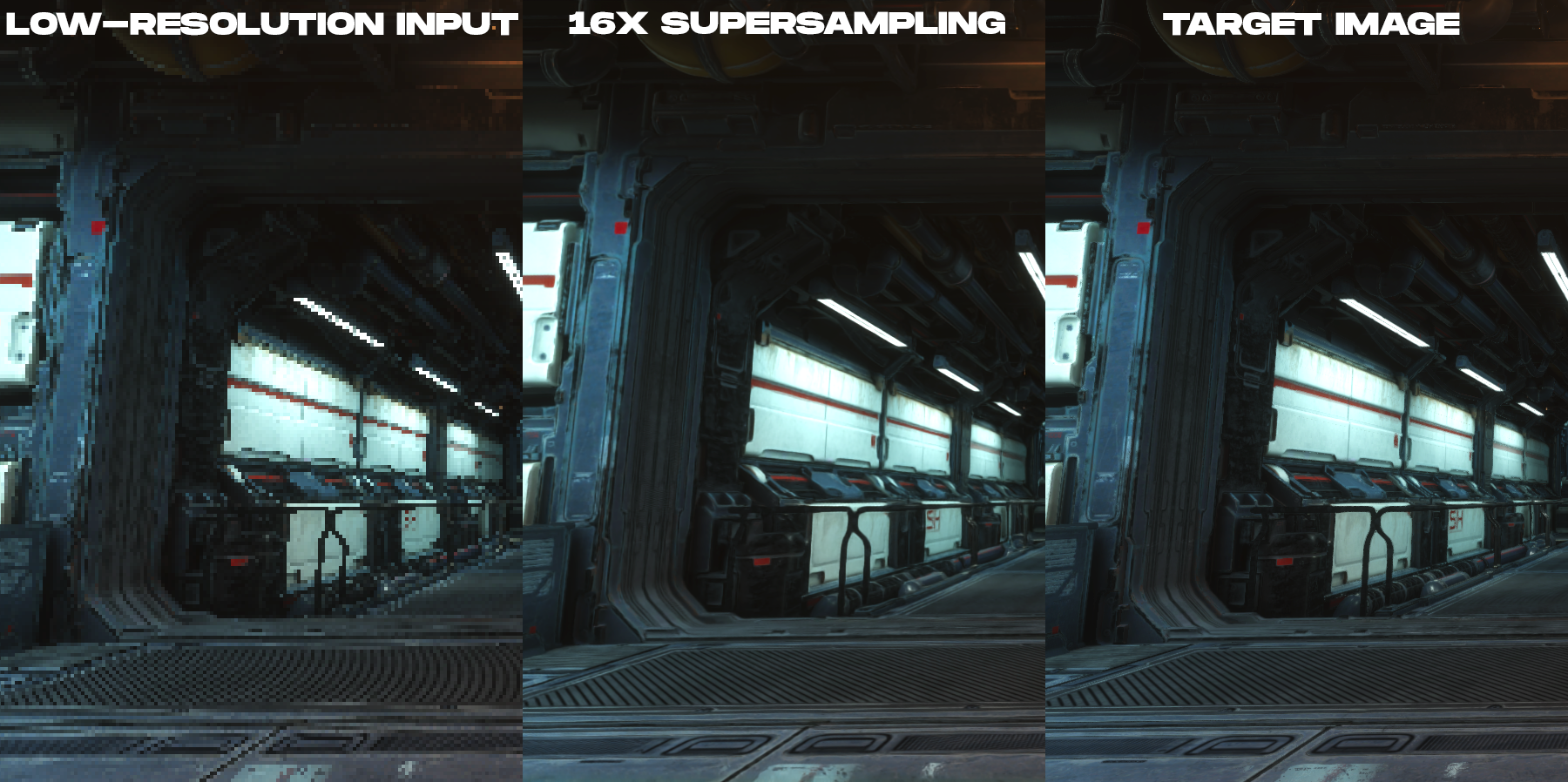

Animation zum Vergleichen des gerenderten Farbbilds mit niedriger Auflösung und des 16x-Supersampling-Ausgabebilds, das mit der neuen neuronalen Supersampling-Technik erstellt wurde.

Worum geht es in dieser Studie?

Um die Kosten für das Rendern auf hochauflösenden Displays zu reduzieren, verwendet unser Verfahren ein Eingabebild, das 16-mal weniger Pixel als das gewünschte Ausgabebild aufweist. Wenn die Zielanzeige beispielsweise eine Auflösung von 3840 × 2160 hat , beginnt das Netzwerk mit einer Eingangsbildgröße von 960 × 540 , otrendernnogo Game Engines, und führt dann das Upsampling auf eine gewünschte Auflösung der Anzeige in Echtzeit-Nachbearbeitung durch.

Obwohl bereits umfangreiche Untersuchungen zum lernbasierten Upsampling von fotografischen Bildern durchgeführt wurden, wurden bei all diesen Arbeiten nicht direkt die besonderen Anforderungen von gerenderten Inhalten wie Bildern, die von Videospiel-Engines erstellt wurden, berücksichtigt. Dies liegt daran, dass zwischen gerenderten und fotografischen Bildern grundlegende Bildunterschiede bestehen. Beim Echtzeit-Rendering ist jedes Sample ein Punkt in Raum und Zeit. Aus diesem Grund neigen gerenderte Inhalte zu starken Verzerrungen, gezackten Linien und anderen Stichprobenartefakten, die in den Beispielen für Bilder mit niedriger Auflösung in diesem Beitrag zu sehen sind. Aus diesem Grund wird das Upsampling von gerenderten Inhalten eher zu einer Aufgabe des Anti-Aliasing und der Interpolation als zu einer Aufgabe der Beseitigung von Rauschen und Unschärfe.Das ist gut von Computer Vision Experten untersucht. Die Tatsache, dass die eingehenden Bilder stark verzerrt sind und absolut keine Informationen für die Interpolation in den Pixeln vorhanden sind, führt zu erheblichen Schwierigkeiten bei der Erstellung einer hochgenauen Rekonstruktion des gerenderten Inhalts mit zeitlicher Integrität.

, ( , ), .

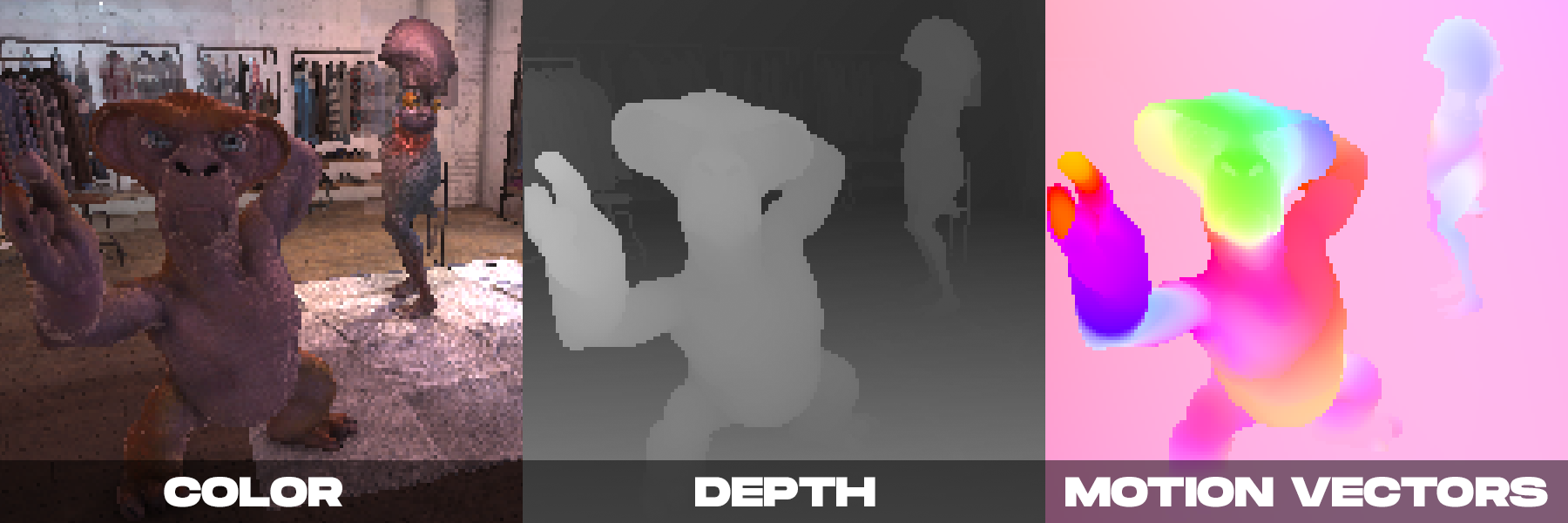

Auf der anderen Seite können beim Rendern in Echtzeit mehrere Farbbilder von der Kamera erzeugt werden. Wie wir in DeepFocus gezeigt haben, bieten moderne Rendering-Engines auch zusätzliche Informationen wie Tiefenwerte. Wir haben festgestellt, dass beim neuronalen Supersampling die zusätzlichen Zusatzinformationen, die von den Bewegungsvektoren bereitgestellt werden, besonders wichtig sind. Bewegungsvektoren definieren geometrische Beziehungen zwischen Pixeln in aufeinanderfolgenden Bildern. Mit anderen Worten, jeder Bewegungsvektor zeigt auf eine Subpixel-Position, an der sich ein in einem Frame sichtbarer Oberflächenpunkt in einem vorherigen Frame befunden haben kann. Für fotografische Bilder werden solche Werte normalerweise unter Verwendung von Computer-Vision-Verfahren berechnet, aber solche Algorithmen zur Berechnung der optischen Bewegung sind fehleranfällig.Im Gegensatz dazu kann die Rendering-Engine dichte Bewegungsvektoren direkt erzeugen, wodurch eine zuverlässige und ausreichende Eingabe für die Anwendung neuronaler Supersampling auf den gerenderten Inhalt bereitgestellt wird.

Unsere Methode basiert auf den obigen Beobachtungen und kombiniert zusätzliche Zusatzinformationen mit einem neuen räumlich-zeitlichen neuronalen Netzwerkschema, das die Bild- und Videoqualität maximiert und gleichzeitig eine Echtzeitleistung bietet.

Bei einer Entscheidung erhält unser neuronales Netzwerk als Eingabe die Rendering-Attribute (Farbe, Tiefenkarte und dichte Bewegungsvektoren jedes Frames) sowohl des aktuellen als auch mehrerer vorheriger Frames, die mit niedriger Auflösung gerendert wurden. Die Ausgabe des Netzwerks ist ein hochauflösendes Farbbild, das dem aktuellen Bild entspricht. Das Netzwerk verwendet überwachtes Lernen. Während des Trainings wird mit jedem eingehenden Frame mit niedriger Auflösung ein hochauflösendes Referenzbild mit Anti-Aliasing-Methoden abgeglichen, das das Zielbild für die Trainingsoptimierung ist.

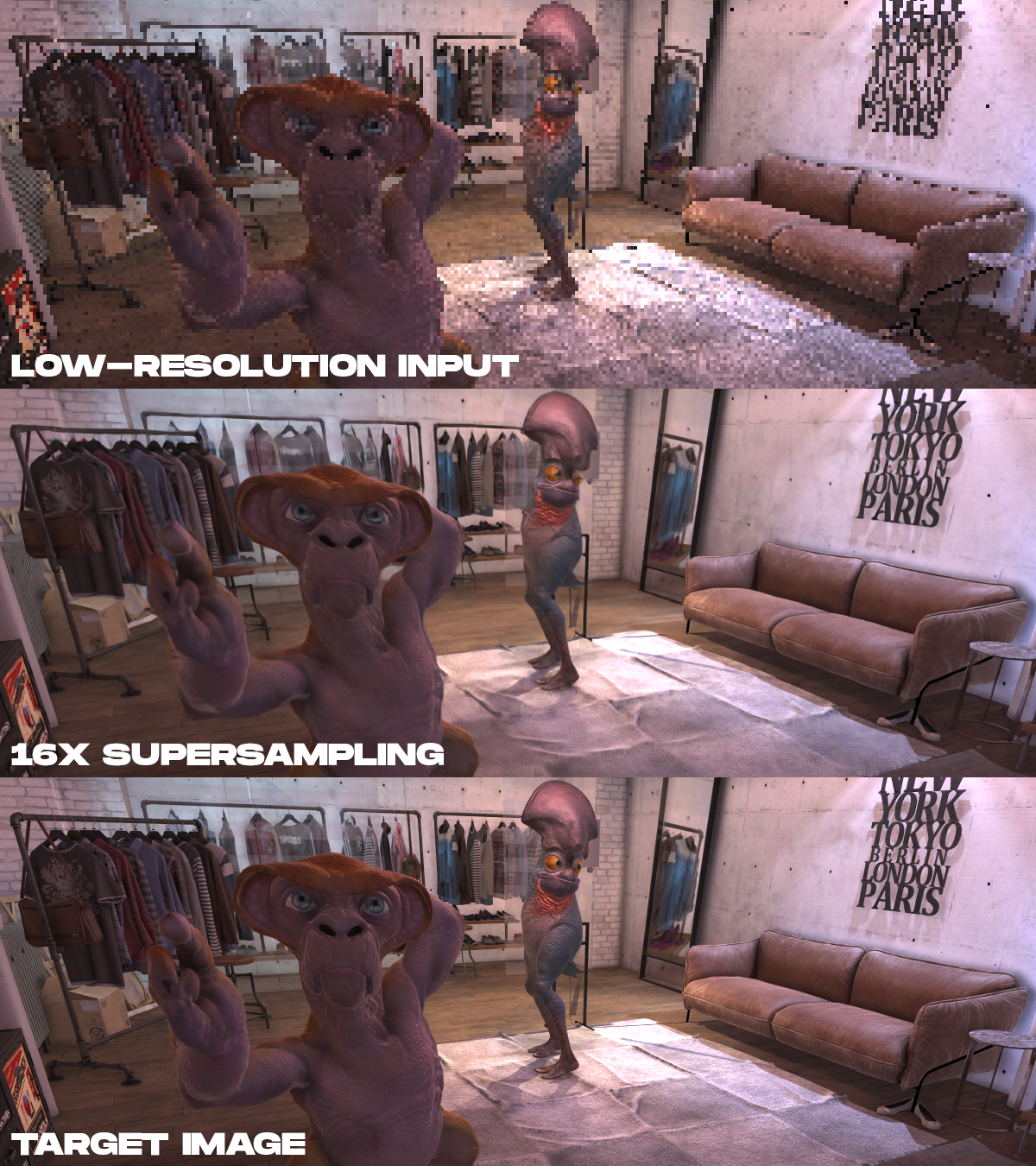

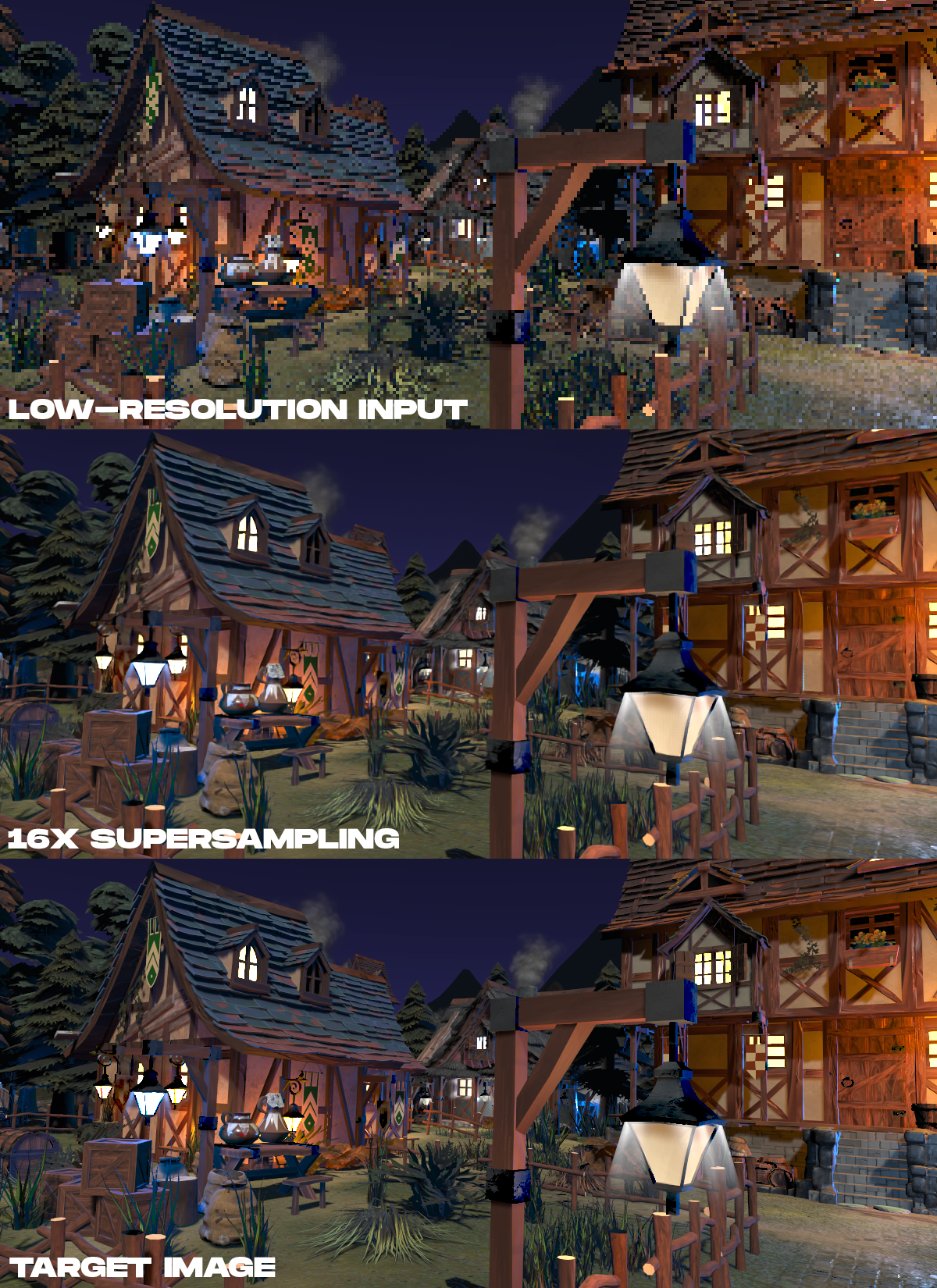

Beispiele für Ergebnisse. Von oben nach unten werden die gerenderten Eingabefarbdaten mit niedriger Auflösung angezeigt, das Ergebnis der 16-fachen Überabtastung, die mit dem vorgeschlagenen Verfahren durchgeführt wurde, und das hochauflösende Zielbild, das in nicht-Echtzeit gerendert wurde.

. , 16 , , , .

. , 16 , , , .

?

Neuronales Rendering hat in AR / VR ein enormes Potenzial. Obwohl diese Aufgabe schwierig ist, möchten wir andere Forscher dazu inspirieren, an diesem Thema zu arbeiten. Da Hersteller von Displays für AR / VR höhere Auflösungen, höhere Bildraten und Fotorealismus anstreben, können neuronale Supersampling-Techniken eine wichtige Methode sein, um genaue Details aus Szenendaten wiederherzustellen, anstatt sie direkt zu rendern. Diese Arbeit macht uns klar, dass die Zukunft der hochauflösenden VR nicht nur in Displays liegt, sondern auch in den Algorithmen, die erforderlich sind, um sie praktisch zu steuern.

Vollständiger technischer Artikel: Neuronales Supersampling für Echtzeit-Rendering , Lei Xiao, Salah Nouri, Matt Chapman, Alexander Fix, Douglas Lanman, Anton Kaplanyan, ACM SIGGRAPH 2020.

Siehe auch: